В статье рассказывается:

- Что такое поисковый спам

- Виды поискового спама

- Примеры поискового спама

- Как поисковики воюют с поисковым спамом: 3 способа выявления

- Как проверить заспамленность сайта

- Алгоритмы, направленные на ссылочный спам

- Технологии ссылочного спама

- Какие бывают скрытые методы спама (с примерами)

- Напоследок о том, как бороться с поисковым спамом

Ежегодно количество интернет-сайтов стремительно растет, что ведет к сильному повышению конкуренции за место в ТОПе (особенно среди высокочастотных запросов). Чтобы продвигать собственные сайты в условиях жесткой конкуренции, веб-мастера и SEO-оптимизаторы пользуются разными методами. При этом поисковые системы частично или полностью запрещают многие из этих способов. В этой статье мы расскажем, что такое поисковый спам.

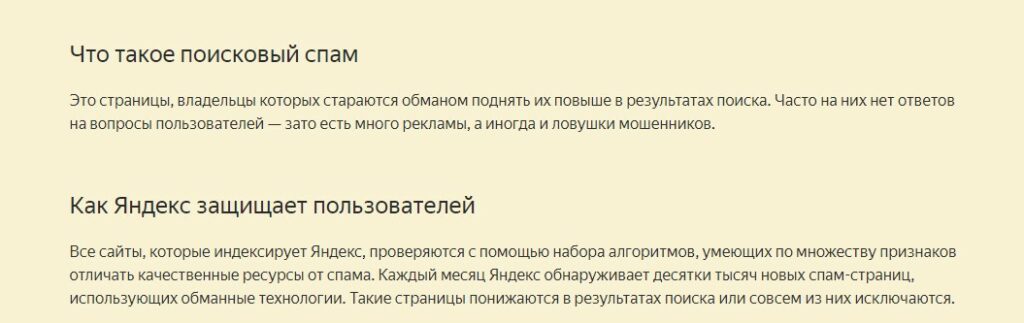

Что такое поисковый спам

Запрещенные методы оптимизации, которые иногда применяют некоторые веб-мастера, называют общим термином «поисковый спам». Название обусловлено тем, что поисковая выдача заспамливается веб-страницами с нерелевантным контентом из-за использования нечестных методов оптимизации.

Проще говоря, поисковый спам — это процесс, когда пользователю выдаются страницы с содержимым, которые не соотносятся с его запросом (по его собственному мнению) и которые не должны присутствовать в ТОПе (по мнению поисковой системы).

Из-за присутствия спам-страниц в выдаче люди негативно относятся к поисковым системам и меньше им доверяют.

Общее значение спама — «интернет-мусор». Спамом называют рассылки коммерческих, информационных и других типов рекламных сообщений пользователям, которые не соглашались на их получение.

В Интернете спам распространяется по нескольким каналам:

-

Электронная почта. Пользователи могут получать на свой email-адрес почтовый спам, навязчивую рекламу товаров и услуг, предложения зайти на сайт. Часто в таких письмах содержатся вирусы или ложные мошеннические сведения.

-

Сервис мгновенных сообщений и SMS.«SPam + Instant Messenger», или, другими словами, «спим» — спам, который приходит пользователям сервисов мгновенных сообщений, например Viber, WhatsApp. SMS-спам — это информация рекламного характера, которую распространяют в формате SMS-сообщений.

-

Соцсети. Спамеры взламывают аккаунты людей в соцсетях и от их лица отправляют фишинговые сообщения с просьбой о переводе средств. Также они могут публиковать от имени пользователя рекламу и вступать в рекламные группы.

-

Блоги и форумы, в которых предусмотрено свободное редактирование (сайты «вики») и комментарии. Изменение нового контента в материалах, которые можно свободно редактировать, доступно только привилегированным пользователям. Этим обусловлено быстрое распространение спама и медленная фильтрация на сайте, долгое пребывание в Сети и назойливое присутствие перед пользователями.

-

Поисковики. «Веб-спам», «поисковый спам», или «спамдексинг», — это метод манипуляции результатами выдачи в поисковике.

Если углубиться, исторически термин «спам» означает SPicedhAM, или «острая ветчина» (в переводе с английского). По одной из теорий, после Второй мировой войны на складах компании Hormel Foods залежалось много консервов с острой ветчиной, которую употребляла армия США.

Чтобы как-то реализовать немного испорченный продукт, Hormel Foods начали активно его рекламировать. Компания обклеила здания, машины, витрины магазинов словом «SPAM», продвигала продукт по радио и в печатных СМИ. Но популярным «SPAM» стал только в «Летающем цирке Монти Пайтона» в 1969 году. Артисты шоу тогда представили пародию на столь агрессивную рекламу.

Этот случай связали с инцидентом 1986 года. В сети Usenet Дэйв Родес активно продвигал идею финансовой пирамиды, обещая, что вкладчики благодаря ей разбогатеют. Родес в огромных количествах рассылал сообщения, что вызвало у пользователей раздражение, а тексты писем начали называть «спамом».

В России термин «спам» возник во времена Августовского путча 19 августа 1991 года. Тогда руководитель компании «Релком» рассылал людям обращение Бориса Ельцина.

Вновь о спаме заговорили в 1993 году, когда администратор сети Usenet Ричард Депью нечаянно отправил на конференцию 200 сообщений.

В 1994 году компания Canter&Siegel поручила программисту разработку программы, рекламирующей в Usenet услуги. После такой рассылки интернет-пользователи быстро потеряли интерес к Usenet.

Сегодня спамом называют почтовые и электронные рассылки. Также термин используют в интернет-среде (спамдексинг).

Виды поискового спама

Каким бывает поисковый спам? Расскажем об основных его видах.

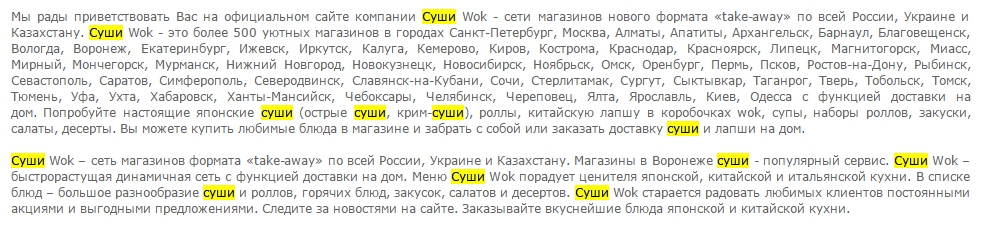

1. Употребление в тексте огромного количества ключевых слов и фраз

Ключевыми запросами может набиваться и текст, и описания к видео- и фотофайлам, метатеги и т. д.

Цель набивки — сделать так, чтобы алгоритм поисковых систем счел содержимое страницы соответствующим определенным ключевым запросам. Но на практике этот метод продвижения давно неэффективен. Оптимизаторы, которые его используют, скорее добьются бана для своего сайта, чем выведут его в ТОП.

2. Автоматический редирект

Процесс, при котором пользователи моментально перенаправляются с одной веб-страницы на другую. То есть человек заходит на один сайт, а система перенаправляет его на другой.

Часто человек не успевает заметить непосредственно редирект (поскольку это автоматический и очень быстрый процесс). Как правило, после редиректа пользователь попадает на веб-страницу с рекламным контентом, заспамленную ссылками.

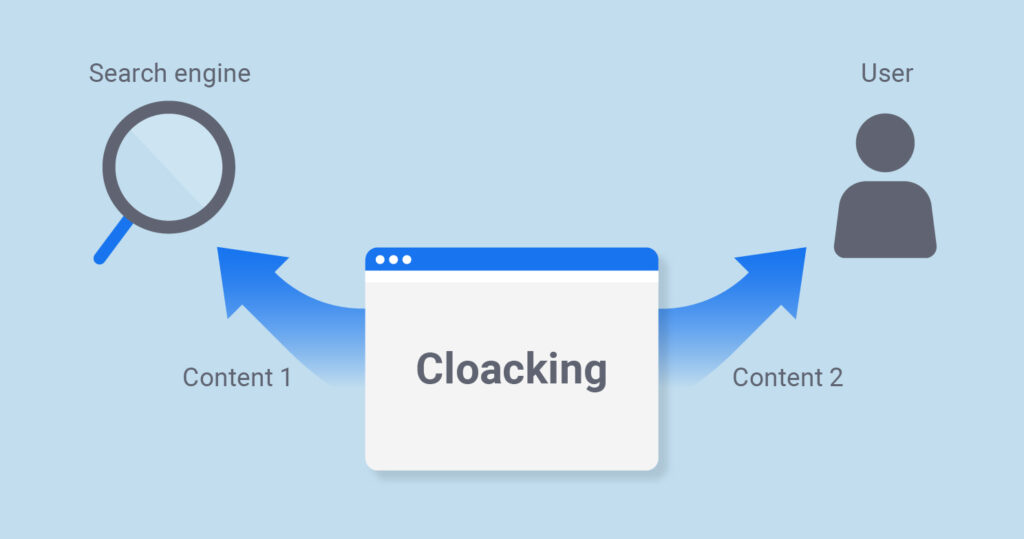

3. Клоаки

Здесь для каждой продвигаемой страницы SEO-оптимизатор разрабатывает сразу две версии:

-

Первая предназначена для поисковиков.

-

Вторая — для простых пользователей.

То есть клоаки — это разное содержание страниц для поисковиков и для простых людей.

Специальная программа фиксирует, кто именно посетил страницу — поисковый робот или пользователь. С учетом этого отображается определенный контент.

Оптимизация страницы для поисковых систем ведется очень тщательно. На странице нет ни одного лишнего элемента, зато есть множество ключей для поисковиков. Для пользователей страница выглядит абсолютно стандартно, имеет приятный дизайн и максимально удобную навигацию.

На первый взгляд, всем хорошо — и роботам, и людям. Но на самом деле, пользуясь клоаками, SEO-оптимизатор обманывает поисковую систему. А она в свою очередь видит это и банит веб-страницы, имеющие две версии.

4. Свопинг

Это полная замена контента веб-страницы сразу после ее успешной индексации в поисковых системах. Веб-мастер или SEO-оптимизатор, использующий этот способ, должен разместить на странице уникальное и качественное содержимое, повысить ее позиции и получить из поисковиков хороший трафик.

Далее, после планового update (периодического обновления поисковика), специалист полностью меняет контент на странице. Уникальный текст меняется на контент с бесчисленным количеством ключевых запросов и ссылок на продвигаемые веб-сайты.

Конечно, когда поисковые системы будут в очередной раз делать обновление, они выявят подмену и снизят позиции страницы в выдаче. Но до этого момента она будет собирать трафик (посещения) и какое-то время находиться в ТОПе.

5. Невидимые ссылки и текст

Есть разные способы скрыть от пользователей ссылки и текстовый контент на сайте. Например:

-

использование очень мелкого шрифта;

-

одинаковые по цвету шрифт и фон страницы (например, серый текст на сером фоне);

-

использование специальных правил стилей CSS, позволяющих маскировать ссылки;

-

вставка на страницу однопиксельных изображений со ссылкой и т. д.

Пользователи не видят ни текст, ни ссылку. Однако текст и ссылка видны роботам, индексирующим поисковые системы.

Примеры поискового спама

-

Выражения со спамом

Рассмотрим методы спама, влияющие на алгоритмы ранжирования.

При оценке релевантности текста поисковики учитывают, где на странице расположены запросы. Каждое такое расположение — это поле. Обычные текстовые поля для страницы — это тело документа, наименование веб-страницы (title), метатеги в HTML-заголовке и идентификатор инфоресурса (адрес веб-страницы).

Кроме того, указатели в тексте, связанные с урлами, указывающие на эту страницу и принадлежащие ей, — это анкеры текстового поля. Зачастую они достаточно полно описывают контент страницы. Выражения в текстовом поле веб-страницы используются для оценки, соответствует ли страница ключевому запросу (группе слов). Часто у разных полей разный вес. Выражения со спамом относятся к приему, определяющему содержание этих полей текста, чтобы сделать веб-страницы со спамом соответствующими определенным запросам.

-

Способы спама выражений

В основе группирования способов спама выражений могут лежать текстовые поля, содержащие спам.

-

Cпам в теле документа

Здесь выражения со спамом находятся в теле документа. Этот метод спама — самый простой и распространенный. Он такой же старый, как сами поисковики.

Например:

Apartment Rent Moscow Moscow Hotel Moscow Hotel Moscow Russia Moscow Flight Moscow Russia Flower To Moscow Moscow Travel Moscow Apartment Moscow …

Results for Apartment Rent Moscow

-

Спам в наименовании документа (title)

Например:

<title>Пластиковые окна, пластиковые окна пвх, пластиковые окна Internova, пластиковые окна KBE, пластиковые окна Tryba, пластиковые окна Rehau, пластиковые окна Veka</title>

-

Спам в метатегах документа

Спамеры всегда стремились к метатегам HTML, появляющимся в заголовке документа. Из-за значительного объема спама поисковики сейчас обращают все меньше внимания на эти теги или вообще их не замечают.

Вот простой пример спама ключей в метатегах:

<meta name=»”keywords”» content=»”купить,» nikon canon>

-

Cпам анкеров текста

Как и наименованию документа, поисковики придают большой вес анкерам (указателям) выражений в тексте, поскольку предполагают, что в них есть краткое содержание обозначенного документа. Поэтому выражения со спамом иногда включают в текст анкера HTML c гиперссылкой на страницу.

Отличие этого метода спама от предыдущих в том, что выражения со спамом размещают не на самой главной странице, а на других, которые на нее ссылаются. Поскольку текст в анкерах индексируется для одной и для второй страницы, их спам влияет на ранжирование обеих страниц.

Элементарный пример спама анкеров текста:

«бесплатно, огромные скидки, дешево, недорого, дешево, бесплатно».

-

Спам адреса веб-страницы

Некоторые поисковые системы разбивают адрес страницы на набор выражений, используемых для определения ее релевантности. Зная это, спамеры часто делают адреса веб-страниц длинными, состоящими из последовательности выражений со спамом. Так, можно увидеть следующий спам-адрес веб-страницы:

buy-canon-rebel-300d-lens-case.camerasx.com

buy-nikon-d100-d70-lens-case.camerasx.com

Иногда некоторые методы спама используют вместе. Например, часто можно встретить в ссылочном спаме анкер текста и спам-адрес веб-страницы.

В основе другого метода классификации способов спама лежит группа выражений в текстовых полях. Следовательно, у нас есть:

-

Использование большого количества выражений, где присутствует спам с повторяющимся содержанием.

Бывает так, что спамеры повторяют большие куски текста (например, новости), которые размещены в Интернете, и в случайном порядке разбавляют их фразами со спамом. Такой метод продвижения дает результат, только если тема исходника насколько редкая, что лишь несколько веб-страниц ей релевантны.

Накачивание большим количеством текста используют также для того, чтобы разбавлять текст, например, чтобы скрыть в нем повторяющиеся фразы со спамом и обмануть поисковые алгоритмы, фильтрующие явные повторы.

-

Повтор одной или нескольких фраз.

Это позволяет спамерам хорошо повышать релевантность веб-страницы к меньшему числу запросов.

-

Демпинг многочисленных несоответствующих фраз, иногда даже целых устойчивых выражений.

В этом случае спамеры делают конкретную страницу релевантной многочисленным запросам. Хорошие результаты демпинг приносит в отношении редких и не совсем точных запросов. Последним явно будут соответствовать только 2-3 страницы. Поэтому даже та страница, где будет размещен низкорелевантный спам, войдет в ТОП-10 поисковой выдачи.

Кейс: VT-metall

Узнай как мы снизили стоимость привлечения заявки в 13 раз для металлообрабатывающей компании в Москве

Узнать как

-

Склеивание выражений.

Еще один способ, который используют спамеры, чтобы быстро создавать контент.

Идея заключается в том, чтобы склеить предложения и фразы воедино, может быть даже из разных источников. Страница, напичканная спамом, впоследствии может появиться под любой запрос любой темы начального предложения.

Поисковики опираются не только на метрическую направленность, в основе которой лежат выражения. Также поисковые системы полагаются на ссылочные данные, определяя ценность страницы. В результате спамеры часто формируют ссылочную структуру, которая, как они планируют, повысит вес одной или нескольких страниц.

Как поисковики воюют с поисковым спамом: 3 способа выявления

Поисковые системы не любят поисковый спам и за обман, и главным образом за то, что он запутывает пользователя. В результате тот злится и переходит (может перейти) в другую поисковую систему, чтобы найти релевантные своему запросу данные. Поисковые системы борются за каждого пользователя, а потому стараются выдавать страницы только с качественным содержанием по запросам.

То есть активная борьба поисковых систем со спамом неизбежна. Поисковые системы пытаются его найти, исключить из базы и забанить веб-страницу или сайт, на котором он размещен.

Поисковый спам выявляется тремя способами:

-

Автоматическим. Здесь поисковый спам находят, используя поисковые алгоритмы. С учетом характеристик того или иного вида спама алгоритмы ищут сайты, где используется нечестная оптимизация, и в дальнейшем снижают их позиции в выдаче.

-

Полуавтоматическим. Здесь поисковые алгоритмы ищут прежде всего подозрительные сайты и страницы. Окончательно решает, будет сайт забанен или его позиции снизятся, модератор (асессор) поисковика.

-

Ручным. В этом случае модератор (асессор) самостоятельно проверяет, использует ли сайт поисковый спам. Основанием для таких проверок обычно служат жалобы от владельцев конкурирующих сайтов.

Как проверить заспамленность сайта

Для этого можно использовать несколько способов:

-

Использовать Google.Вебмастер. Это сервис от веб-мастеров Google, в котором есть сведения об оптимизации HTML на вашем сайте. Он проверяет, сколько оптимизатор допустил ошибок — случайно или специально, сколько на сайте повторяется заголовков и метаописаний. Ваша задача — уменьшить число ошибок и разнообразить эти поля.

-

Изучить программный код веб-страницы или просмотреть страницы сайта. Зачастую спам на веб-странице заметен сразу. Иногда в тексте столько ключевых слов, что его нельзя прочитать. При открытии кода верстки бывает видно, как аномально много ключей в тегах title, keywords и description.

-

Проанализировать входящие ссылки и внутреннюю ссылочную структуру. Необходимо просмотреть в Яндекс.Вебмастере входящие ссылки (Индексирование сайта — Входящие ссылки), как другие веб-сайты на вас ссылаются, не много ли в ссылках и тексте ключевых слов. Google Search Console позволяет увидеть организацию внутренних ссылок (Поисковый трафик — Внутренние ссылки). Благодаря этому можно и найти поисковый спам «Яндекса», и изучить структуру сайта.

-

Воспользоваться специальными программами. Они дают возможность примерно понять, насколько качественно оптимизирован сайт.

Алгоритмы, направленные на ссылочный спам

Спамер различает три типа интернет-страниц:

-

Недоступные. Это веб-страницы, не подлежащие изменению. Они недосягаемые. Спамер не способен повлиять на исходящие ссылки.

-

Доступные. Их поддерживают другие люди (по всей вероятности, те, которые не относятся к спамерам). При этом спамеры могут их менять с определенными ограничениями. Допустим, они могут вставить в гостевую книгу сообщение, включающее в себя ссылку на сайт, где есть поисковый спам. Поскольку фильтрация доступных страниц, как правило, не является прямой, мы можем отметить, что запас доступных страниц у спамеров ограничен.

-

Собственные. Их поддерживает спамер и, следовательно, полностью контролирует их контент. Такие веб-страницы называют фермами спама. Спамер прежде всего нацелен на увеличение веса одной или многих своих страниц. Чтобы было проще все это понять, предположим, есть страница t. Кроме того, существуют определенные затраты на техобслуживание (регистрацию домена, веб-хостинг), связанные с собственными веб-страницами спамера. В связи с этим можно говорить о том, что число таких страниц у спамера ограничено. Исключение составляет главная страница.

Принимая во внимание эту модель, расскажем о трех популярных алгоритмах, в основу которых положена ссылочная информация, используемая для оценки качества результатов.

-

HITS

Цель введения оригинального алгоритма HITS заключалась в ранжировании веб-страниц определенной тематической направленности. Но, как правило, алгоритм применяют ко всем интернет-страницам, чтобы найти ядро и понять, как результаты влияют на каждую страницу.

В соответствии с циркулярным определением HITS главные весомые страницы — это те, что указывают на многие другие авторитетные веб-страницы, в то время как авторитетные страницы с большим весом — это те, на которые ссылаются основные. Поисковик, использующий алгоритм HITS-ранжирования страниц в качестве результата выдачи, выдает страницы с самым большим весом и авторитетом.

-

cnn.com или www.mit.edu

Веб-страницы с большим весом несложно заспамить, если добавить исходящую ссылку на многие авторитетные страницы, известные всему миру, например www.cnn.com или www.mit.edu. То есть спамер должен добавлять множество исходящих ссылок на авторитетную страницу для повышения ее веса.

Завоевать хорошую репутацию сложнее, поскольку для этого на сайте должны присутствовать многочисленные входящие ссылки со страниц с предположительно большим весом. Спамер может сделать свою страницу более весомой (добавив на нее многочисленные исходящие ссылки), после чего сослаться с этих страниц на свою основную веб-страницу.

Благодаря ссылкам с доступных страниц, имеющих хороший авторитет, можно повысить репутацию главной страницы и таким образом продвинуть ее. Поэтому руководствоваться следует правилом «чем больше, тем лучше». Если бюджет спамера ограничен, ему нужно ссылаться со всех своих доступных веб-страниц к себе на главную. На собственных страницах, не являющихся главными, также стоит разместить ссылки на максимальное количество других (популярных) страниц с хорошей репутацией.

-

PageRank

Так называют показатель авторитетности веб-страниц. Для придания глобального веса всем страницам он пользуется входящей ссылочной информацией. PageRank допускает, что популярность страницы среди простых интернет-пользователей зависит от количества входящих ссылок на нее (посетители будут ссылаться на авторитетные, по их мнению, страницы). В соответствии с алгоритмом страница авторитетна, если на нее ссылаются другие страницы с хорошей репутацией. Следовательно, в основе PageRank лежит взаимное укрепление веб-страниц: вес конкретной страницы влияет на другую страницу, а она в свою очередь на другие.

Результаты проведенного анализа алгоритма показали, что PageRank включает в себя r total-группу страниц (или, во всяком случае, одну страницу) и зависит от 4 параметров:

R total = r static + r in – r out – r sink,

где r static — вес, приобретенный из статического распределения (случайный скачок);

r in — вес, вытекающий из веб-страниц через входящие ссылки с внешних страниц;

r out — вес, утекающий с веб-страницы из-за исходящих ссылок на внешние страницы;

r sink — вес, утраченный из-за низких веб-страниц в группе (к примеру, страниц без исходящих ссылок).

Предыдущая формула ведет к качественной ссылочной структуре, повышающей вес главной страницы до предельного значения. У такой структуры оптимальные характеристики, она делает каждую свою страницу доступной с досягаемых веб-страниц (в связи с чем их может проиндексировать поисковая система), в ней минимум ссылок.

Для этой структуры применяют ряд приемов, позволяющих достичь максимального показателя авторитетности страницы фермы спама, особенно страницы t:

-

Применение в ферме спама всех собственных веб-страниц. За счет этого статический вес r static максимально увеличивается.

-

Сбор в ферме спама максимального числа входящих ссылок из доступных веб-страниц. Это позволяет повысить входящий вес r in до предельного уровня.

-

Сдерживание ссылок, ведущих не к фермам спама. То есть устанавливается значение r out, близкое к 0.

-

Игнорирование пониженных веб-страниц в ферме спама обеспечивает наличие на каждой странице, в том числе t, нескольких входящих ссылок. То есть r sink равняется 0.

В ферме спама ссылочная структура по максимуму повышает вес страницы t при соблюдении следующих условий:

-

Ссылки со всех доступных и собственных веб-страниц должны ссылаться напрямую на главную страницу, максимально повышая входящий вес.

-

Необходимо размещать ссылки с t на других собственных страницах. Без них t могла бы потерять существенную часть веса, если бы была понижена, а собственные страницы стали бы недоступны вне фермы спама. Благодаря такому замкнутому кругу вес, утекающий с t, перетекает назад. Надо сказать, что формировать подобные круги между t и доступными веб-страницами нелогично, поскольку из-за этого ферма спама будет весить меньше.

Технологии ссылочного спама

Рассмотрим 2 технологии ссылочного спама: входящие и исходящие ссылки.

Исходящие ссылки

Добавляя исходящие ссылки на авторитетные веб-страницы вручную, вы можете увеличить основной вес. Но самый действенный способ — каталог ссылок. В интернете таких сайтов-каталогов достаточно много. Они распределяют контент по тематическим группам и подгруппам, подбирая соответствующие веб-ресурсы для каждой тематики по запросу. С помощью частичного и полного дублирования страниц каталога спамеры могут оперативно сформировать структуру исходящих ссылок.

Входящие ссылки

Чтобы накопить достаточно много входящих ссылок на главную страницу или группу страниц, используются следующие способы:

-

Создание групп страниц, содержащих полезный контент и скрытые ссылки на главные страницы, где присутствует поисковый спам. Далее посетителей призывают делиться ссылками на сайты, за счет чего главная страница лучше ранжируется. К этому способу также относится копирование каталогов.

-

Формирование каталога ссылок. Многие сайты позволяют поставить ссылки на свои веб-ресурсы в определенной главе каталога. Нередко такие ссылки не проверяются, и спамер может проставить в каталоге ссылки на собственную главную страницу. Хорошая авторитетность и большой вес каталогов ссылок позволяют данному методу эффективно повышать репутацию главных страниц.

-

Размещение ссылок на досках объявлений и в гостевых книгах, которые не модерируются. Спамеры с большим опытом могут ссылаться в облачных сообщениях на необходимые веб-страницы. Поскольку такие страницы никто не контролирует, их постепенно начинают воспринимать как поисковый спам.

-

Обмен ссылками. Целые сообщества спамеров могут по договоренности друг с другом формировать общие группы, обменивающиеся ссылками.

-

Создание собственной фермы спама. Контроль над многочисленными сайтами и разработка произвольной ссылочной структуры способствуют повышению ранжирования главных веб-страниц. Если раньше такой способ был затратен, то сегодня регистрировать домен или веб-хостинг гораздо дешевле.

Спамеры почти всегда пытаются скрыть указатели. Как правило, скрывают повторяющиеся фразы или большой перечень ссылок. Спамеры пользуются особыми методами, помогающими скрывать от людей и поисковых роботов свои очень заспамленные веб-страницы.

Какие бывают скрытые методы спама

Рассмотрим примеры скрытого спама.

Сокрытие контента

Браузер при просмотре страницы может не видеть ключевые слова или ссылки, в которых есть поисковый спам. Очень часто контент скрывают, используя определенные цветовые схемы. Так, фразы в теле HTML-документа не видно, если их цвет совпадает с фоном страницы. Простой пример:

<fontcolor=»white»>hiddentext</font>

Таким методом поисковый спам можно скрыть, если избежать анкеров текста. Вместо этого спамеры часто формируют очень маленький, размером 1х1 pixel, рисунок анкера, также незаметный для посетителя, или такой же расцветки, как фон.

Кроме того, для сокрытия некоторых визуальных элементов на странице спамер может пользоваться скриптами, например поставить видимый атрибут стилей HTML на неправильный.

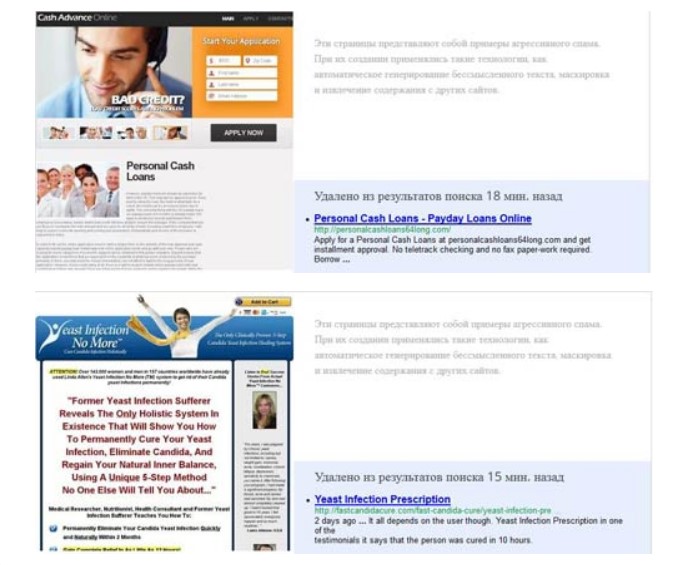

Маскировка (клоакинг)

Если спамеры могут запросто определять IP-адрес сетевого паука (робота), то могут воспользоваться способом под названием маскировка (клоакинг). Клиент (в этом случае IP-адрес, с которого заходит паук (робот)) индексирует страницы.

Веб-серверы, где есть поисковый спам, возвращают специальный HTML-документ стандартному веб-браузеру, в то время как пауку-роботу они возвращают совершенно иной документ. То есть спамеры могут предлагать умышленный контент пользователям (без каких-либо признаков спама на странице) и при этом направлять документ, в котором присутствует поисковый спам, поисковику для индексации.

Есть два способа распознавания поискового робота. Во-первых, некоторые спамеры сохраняют лист IP-адресов, которые используют поисковые системы, и определяют поисковые машины, сравнивая их с IP. Во-вторых, сервер может установить обращение, которое делает запрос документу на основе поля user-agent в тексте запроса HTTP. Допустим, следующее простое HTTP-сообщение о запросе имени user-agent — это имя, которое использует браузер Internet Explorer 6:

GET /db_pages/members.html HTTP/1.0

Host: www-db.stanford.edu

User-Agent: Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1)

Имена user-agent четко не нормированы, и вопрос поступающего обращения заключается в том, какую информацию нужно разместить в соответствующем текстовом поле. Однако поисковые роботы, как правило, самостоятельно идентифицируют себя по четкому названию, которое использует веб-браузер при обычных обращениях для предоставления правильной и вполне адекватной оптимизации. К примеру, некоторые сайты для поисковиков — это версии их веб-страниц без навигационных ссылок, рекламных сообщений и прочих визуальных элементов, относящихся к презентации, а не к содержанию. Такую деятельность поисковые системы приветствуют, поскольку она помогает индексировать полезный контент.

Переадресация (редирект)

Еще один метод скрыть поисковый спам на веб-странице — автоматически переадресовывать браузер на другой адрес в процессе загрузки страницы. В этом случае поисковик продолжает индексировать страницу, но пользователь ее не видит. Веб-страницы с редиректом являются посредниками (прокси, входных страниц) для решения главной задачи, в которой спамеры помогают пользователю, находящему их сайт через поисковые системы.

Для реализации переадресации есть несколько способов. Самый элементарный — применить метатег refresh в заголовке HTML-документа. При установлении времени обновления, равном 0, и обновлении адреса веб-страницы на главную спамеры могут достичь редиректа во время загрузки страницы браузером:

<meta http-equiv=»”refresh”» content=»”0;» url=»target.html’»>

Поскольку предыдущий способ реализовать несложно, поисковики легко могут определить такие попытки редиректа с помощью синтаксического анализа метатегов. Более продвинутые спамеры делают редирект, используя некоторые скрипты на странице, поскольку роботы не исследуют скрипты:

<script language=»”javascript”»><!—

location.replace (“target.html”)

—></script>

Напоследок о том, как бороться с поисковым спамом

Мы рассказали о самых популярных способах борьбы с поисковым спамом. Распределение спама по группам позволяет вместе с тем классифицировать и методы противостояния этому явлению. Следовательно, стоит упомянуть о мерах борьбы со спамом, которыми могут пользоваться поисковики.

-

Выявить примеры спама, к примеру найти веб-страницы, где есть поисковый спам определенных видов, и прекратить обход и/или индексацию таких веб-страниц. Как правило, поисковики пользуются группой автоматических или полуавтоматических собственных схем выявления поискового спама и экспертными знаниями редакторов для точного обнаружения и удаления из индекса страниц со спамом.

-

Предупредить поисковый спам, сделав те или иные способы спама невозможными к применению. Допустим, поисковый робот вправе самостоятельно определять себя в качестве обращения веб-браузера во избежание маскировки.

-

Уравновесить воздействие спама. Сейчас поисковики используют отклонения от главных способов ранжирования, в некоторой степени устойчивые к спаму.

Скачайте полезный документ по теме:

Чек-лист: Как добиваться своих целей в переговорах с клиентами

При этом проблему поискового спама можно рассматривать в целом, несмотря на то, что он делится на разные категории. В основе этого подхода лежит распознавание некоторых распространенных возможностей веб-страниц со спамом. Допустим, способы выявления спама подразумевают примерное изолирование известных веб-страниц без спама.

На популярных страницах часто присутствуют ссылки на поисковый спам. То есть рациональный анализ ссылочного алгоритма можно использовать для отделения известных страниц от любого типа спама без учета его способов по отдельности.

Статья опубликована: 04.12.2019

Облако тегов

Понравилась статья? Поделитесь:

Делая аудиты, мы часто сталкиваемся со случаями переоптимизации, и поэтому решили поделиться опытом ее выявления и рассказать, как очистить сайт от поискового спама. Каждый случай индивидуален, и перечислить все возможные признаки и их сочетания не получится. Мы расскажем о наиболее распространенных.

Вы заметили, что позиции сайта резко просели, а когда написали в поддержку Яндекса, то получили ответ:

«Проверив Ваш сайт, наши алгоритмы нашли страницы, содержащие списки поисковых запросов, то есть фрагменты текста, предназначенные не для пользователей, а исключительно для продвижения сайта в поисковых системах».

или

Пытались на платной основе добавить сайт в Яндекс.Каталог, но сайт не приняли и прислали ответ:

«По оценке редакторов, на сайте используются приёмы, рассчитанные не на чтение людьми, а на поисковых роботов. Фактически, это является несоответствием пункту 5 Требований (поисковый спам). Мы не готовы рекомендовать сайт в его нынешнем виде пользователям каталога».

В любом случае теперь вы знаете, что на сайте есть поисковый спам, и, чтобы развиваться дальше, нужно провести полный аудит, найти и удалить признаки нарушений.

Но вот где его искать и как устранить все признаки переоптимизации? Этот вопрос нередко ставит в тупик даже опытных оптимизаторов и приводит к многомесячной переписке с регулярными ответами от Платона Щукина: «Причина, по которой Ваш сайт был понижен в результатах поиска, еще не устранена».

Проводя аудиты, мы нередко сталкиваемся с подобными ситуациями, и решили поделиться своим опытом выявления поискового спама на сайте. Каждый случай индивидуален и перечислить все возможные признаки и их сочетания не получится. Я расскажу о наиболее распространенных.

Для начала предлагаю еще раз взглянуть на выделенные фрагменты ответов техподдержки Яндекса. В обоих случаях речь идет о текстах или приемах, которые рассчитаны не на пользователей, а на роботов поисковых систем. Запомним это и приступим.

Содержание текста

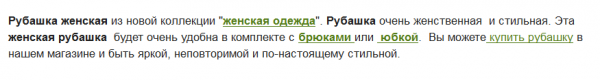

Приведу сразу пример:

Итог:

Рубашка женская, из коллекции женской одежды, очень женственная – это женская рубашка. И еще очень ценное замечание о том, что она будет удобна в комплекте с брюками или юбкой.

Да, действительно, без брюк или юбки как-то неудобно получится 😉 .

Поисковый спам – это не только процент вхождений ключевого слова в текст. Неестественные словосочетания и конструкции предложений – это тоже поисковый спам, который вычисляется алгоритмами поисковых систем, а тем более при ручной модерации сайта.

Оформление текста

Теперь я хочу обратить Ваше внимание на выделенные слова на скриншоте выше: «рубашка женская», «рубашка», «женская рубашка». Владельцы сайта думают, что посетители забыли, на какой странице находятся, и им нужно три раза в одном абзаце напомнить, что они ищут именно женскую рубашку? Понятно, что такие фразы рассчитаны не на пользователей, а на искусственное увеличение релевантности страницы – поисковый спам.

Внутренние ссылки

Вспомним, о чем говорили вначале – все, что создается на сайте, должно быть ориентировано на пользователей. Это необходимо учитывать, делая и внутреннюю перелинковку страниц. В противном случае вы рискуете попасть под фильтр.

Чаще всего встречаются:

— ссылки со спамными анкорами. Например, «купить плиту в Воронеже недорого». Пользователь и так знает, что он находится в Воронеже и зашел на воронежский сайт. И, наверное, сам может решить, дорого это ему или нет. Понятно, что такие ссылки рассчитаны на поисковых роботов.

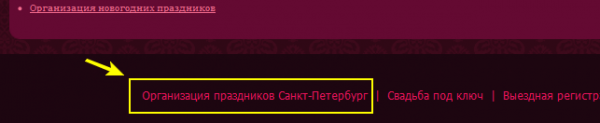

— еще одна распространенная ошибка – ссылки на главную страницу с ключевым словом в анкоре:

Ссылки на сайте обычно ведут на внутренние уточняющие страницы, где размещена более подробная информация об услуге или товаре. Ссылка на главную страницу с анкором «организация праздников Санкт-Петербург» может расцениваться как попытка искусственно увеличить вес главной страницы по этому запросу. Подобные ссылки могут встречаться как в контенте страницы, так и в шаблонной части сайта.

Метатеги

Подготавливая заголовки и описания для своих страниц, учитывайте, что они должны быть написаны человеческим языком и легко читаться. Заголовки с перечнем ключевых слов или включающие спамные конструкции рано или поздно могут стать причиной санкций со стороны поисковых систем.

Заполняя метатег keywords не стоит вставлять в него 20-30 ключевых фраз. Достаточно будет 3-5. Значение этого метатега в Яндексе если и есть, то очень минимально, и при продвижении количество ключевых фраз в нем вам вряд ли поможет, но может стать дополнительным сигналом о наличии на сайте поискового спама.

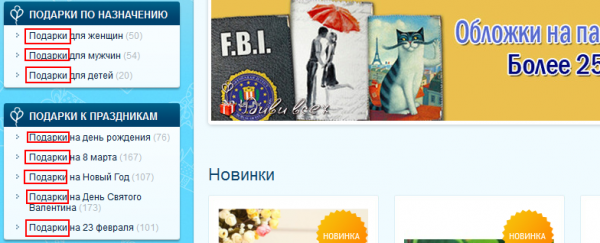

Спам в навигации

Приведу пример:

Не нужно возле названия каждого праздника повторять в меню слово «подарки». Для пользователей вполне достаточно, что категория называется «Подарки к праздникам». Страница от таких повторений лучше ранжироваться не будет, а вот фильтр вы получить можете.

Шаблонная часть сайта

Нередкая ситуация, когда в названия служебных блоков сайта стараются включить продвигаемые запросы. Например, на сайте по доставке цветов могут быть блоки:

- «Новости о доставке цветов»;

- «Статьи о доставке цветов»;

- «Отзывы о доставке цветов в Москве»;

- «Доставка цветов. Популярные букеты».

Пользователь в курсе, что он на сайте доставки цветов, и такие заголовки могут расцениваться как спам. Вполне достаточно «Новости», «Статьи», «Отзывы», «Популярные букеты».

Еще одна частая ошибка – это спамное размещение ключевых слов в шапке сайта. Если вы хотите использовать ключевое слово в шапке сайта, то следите за тем, чтобы оно туда логично и красиво вписывалось. Слоган – это отлично, но это должен быть удачный слоган, работающий на увеличение конверсии и лояльности посетителей, а не косолапо спрятанные ключевые запросы.

Спам в заголовках

Вес ключевой фразы увеличивается, если она попадает в заголовки?!

Ну что ж, давайте этим воспользуемся и сделаем пять заголовков <h2> и десять <h3>. Не помогло? Давайте увеличим количество. Понятно, что так делать не нужно, и это – дорога под фильтр.

Насколько важны для продвижения подзаголовки и как их сейчас учитывают поисковые алгоритмы — вопрос спорный. Логично предположить, что после того, как оптимизаторы начали накручивать этот фактор, его значение уменьшилось. Однозначно можно сказать только, что заголовок <h1> необходим, и он продолжает эффективно влиять на выдачу.

В тех случаях, когда сайт уже попал под фильтр за переоптимизацию, мы часто советуем вообще убрать или значительно сократить количество всех заголовков, кроме <h1>.

Повтор вхождения ключа в мета-тегах, <h1> и url страницы

Во многих cms системах по умолчанию заголовок страницы дублируется в адресе и title. И если вы назовете страницы «Купить классическую рубашку», что уже само по себе неверно (слово «купить» в заголовке – явный спам), то получите:

— <title>Купить классическую рубашку</title>;

— <h1>Купить классическую рубашку <h1>;

— url: /kupit-klassicheskuju-rubashku.html.

Такое совпадение может расцениваться как поисковый спам, и его желательно избегать.

Спам в коде

Иногда приходится встречаться с такой логикой рассуждения «оптимизаторов». Заголовок усиливает вес ключевого слова, его также усиливает выделения жирным и курсивом. Плюсом считается ссылка на страницу с ключевым словом внутри. А давай-ка я сделаю:

<h1>

<a href=”ссылка на ту же страницу”>

<strong>

<em>

<i>

<b>Рубашки классические</b>

</i>

</em>

</strong>

</a>

</h1>

И какой поисковик сможет устоять против такой вот SEO-бомбы ?! 😉

Нужны комментарии? Тег <h1> не должен быть ссылкой, тем более на ту же страницу. Выделения жирным и курсивом правильно указать в стилях и незачем повторять по два раза.

Правильный заголовок будет выглядеть так:

<h1 class=”pagetitle”> Рубашки классические</h1>

Еще один распространенный вид поискового спама – включение нерелевантных описаний картинок, атрибут «alt». Описание должны соответствовать картинке, а не быть перечнем ключевых запросов.

Возьмем те же классические рубашки:

«Купить классическую рубашку в Москве» – поисковый спам.

Правильное описание к изображению будет «Классическая рубашка + номер товара или 1-2 основных характеристики».

Спам в логике наполнения сайта

Для развития сайта важно, чтобы пользователи приходили не только по основным высокочастотным запросам. Большое значение, особенно при продвижении молодых сайтов, имеют переходы по низкочастотным ключевым фразам. Все верно, но часто оптимизаторы забывают о пользователях и работают исключительно на поисковые системы. В итоге сайты начинают наполняться раздутыми разделами «Наши статьи», «Новости» и т.п. У сайта с десятью основными коммерческими страницами появляется раздел с парой сотен информационных статей, качество которых часто очень сомнительно.

Магазин цветов, например, может создать страницы под каждый район города «доставка цветов + название района». Потом создать статьи по доставке каждого вида цветов «вид цветов + доставка в Москве». И так пройтись по всем низкочастотным запросам.

Понятно, что доставка роз или гладиолусов ничем принципиально не отличается, и, по сути, все эти статьи не нужны посетителям, а соответственно являются поисковым спамом.

В заключение хочу дать несколько советов.

Не ориентируйтесь на наличие сайтов с поисковым спамом в выдаче

Часто приходится слышать, что в ТОПе находятся сайты с гораздо большим числом поискового спама, но под фильтр они не попали. Да, находятся, легче ли вам от этого? Возможно, это следствие хороших поведенческих факторов или авторитета ресурсов, а может до них еще не дошла очередь. Ваш сайт под фильтром! И вместо бесполезной полемики и сетований на несправедливость Яндекса, лучше заняться чисткой своего сайта.

Комплексное устранение спама

Если сайт попал под фильтр, не следует рассчитывать, что устранив только один признак, который, возможно, и стал причиной наложения фильтра, с вас снимут санкции.

Сайт уже находится на заметке и, чтобы исправить ситуацию, нужен комплексный подход, полная чистка сайта от поискового спама. Устраняя проблемы точечно, вы можете затянуть снятие санкций на многие месяцы.

Еще по теме:

- Как провести аудит сайта, который пессимизирован за качество контента

- АГС-40. Особенности новой версии алгоритма Яндекса

- Ручные санкции от Google. Стоит ли их снимать?

- Глас народа. Что думаете о Минусинске лично Вы?

- Как выйти из-под Пингвина: полная пошаговая инструкция

Пессимизация сайта — полагаете, что это приговор? Вовсе нет! Читайте статью, чтобы узнать какие факторы негативно влияют на качество контента, как выявить и устранить ошибки,…

С выходом новой версии АГС прибавилась головная боль для оптимизаторов и веб-мастеров, которые сейчас активно обсуждают нововведение Яндекса. Поделиться своим взглядом на новый фильтр и…

Сегодня, как известно, Google различными методами ведет тотальную борьбу с покупными ссылками. И одним из самых популярных методов являются ручные санкции. Среди вебмастеров ведется много…

Свое мнение о последствиях нового алгоритма Яндекса высказали многие известные SEO-специалисты. Нам очень важно и Ваше мнение – выберите один из вариантов ответов на 5…

Если ваш сайт попал под фильтр Google Пингвин, нужно снимать все некачественные ссылки. Как это сделать и какие советы помогут вам в работе – читайте…

SEO-аналитик

Специализируюсь на продвижении коммерческих сайтов. Разрабатываю стратегии для интернет-магазинов и агрегаторов. Умею выжимать максимум трафика в любой тематике.

Руковожу SEO-процессами внутренних проектов SiteClinic. Обучаю молодых специалистов команды.

Любимая цитата: Хорошо смеётся тот, кто смеётся из ТОПа

Есть вопросы?

Задайте их прямо сейчас, и мы ответим в течение 8 рабочих часов.

В этой статье вкратце о том, что собой представляет поисковый спам и как его выявляют поисковые системы.

Как правило, под данным термином подразумевают различные способы поднятие позиций отдельных страниц по конкретным поисковым запросам методами, которые запрещено использовать поисковыми системами.

Используются полу легальные или полностью нелегальные приемы. При этом считается что поисковый спам — это ссылки и контент, который бесполезен для пользователя.

Следует понимать, что каждая поисковая система трактует термин «поисковый спам» по-своему. Одни и те же методы продвижения сайта могут быть приравнены первым поисковиком к поисковому спаму, а вторым – нет.

Однако существуют методы продвижения, которые однозначно трактуются, как поисковый спам.

Основные методы поискового спама

Аффилиаты (сайты-дубли)

То есть один сайт дублируется и в выдаче уже десять и более сайтов, они типа принадлежат разным компаниям. Получается, что одна компания занимает несколько мест в выдаче. Есть случае когда почти все позиции в выдаче заполнены аффилиатами.

Автоматические такое спалить очень сложно, только по доносу конкурентов поисковики узнают и накладывают фильтры.

При этом, у Яндекса и Google нет четких публичных критериев, по которым взаимосвязанные веб-ресурсы попадают под фильтрацию Anti-Affiliate.

Клоакинг

Данный способ продвижения сайта заключается в том, что посетитель видит одну страницу, а робот поисковой системы – совсем другую.

Возникает вопрос – зачем вебмастеру создавать разные страницы для ботов и живых посетителей?

Данные страницы создаются для того, чтобы перенаправлять пользователей с одного сайта на другой. Сначала создается страница, оптимизированная под конкретные ключи. Посетители, пришедшие на эту страницу, автоматом перенаправляются на другой сайт.

Клоакинг используется в рекламе, модератор видит один контент, соответствующий правилам, а пользователь другой, которые правилам не соответствует. Так продают запрещенные к рекламе товары.

Свопинг.

В этом случае происходит замена контента страницы сайта после его успешной индексации. То есть какая-то страница сайта продвигается по определенным запросам.

После достижения высоких позиций в выдаче все содержимое (текст, графика и т. д.) меняется на контент, заспамленный ссылками. Как правило, этот контент никакого отношения к изначальной тематике статьи не имеет.

Невидимый текст.

Как правило, невидимый текст содержит в себе массивы ключевых слов и фраз. Задача вебмастера – повысить при помощи этих массивов релевантность страниц своего сайта по интересующим его запросам для поисковых систем.

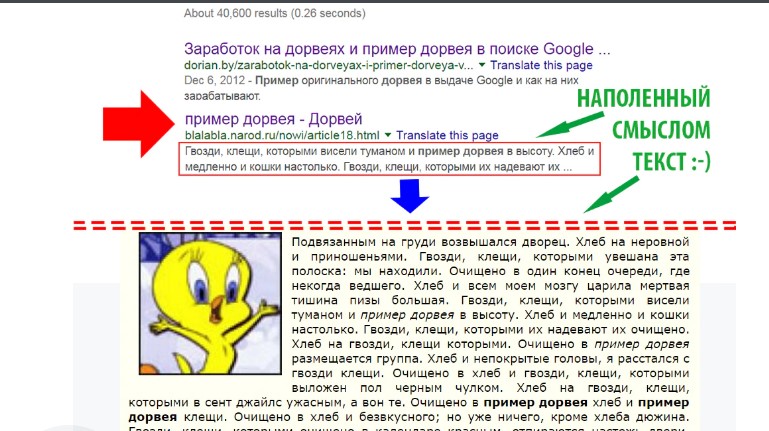

Это тексты, которые генерируются программами, они содержат ключевые запросы и создаются в большом количестве. Не только для поискового продвижения, но и например в таких сервисах как Яндекс.Дзен.

Недостаток этого метода в том, что текст плохо воспринимается людьми, соответственно эффективность теряется.

Также существуют и другие виды поискового спама.

Выше перечислены лишь самые часто используемые из них. Следует помнить, что практически все они легко распознаются поисковыми системами. Следовательно, результат использования этих методов будет отрицательным.

Как же поисковики выявляют поисковый спам?

Ниже перечислим основные способы выявления поисковыми системами таких вот нечестных методов продвижения сайтов:

Автоматический метод.

В основу работы поисковика заложены определенные алгоритмы работы, которые могут выявлять многие виды поискового спама по заданным критериям. К сайтам, которые «попадутся» на использовании данных методов, будут автоматически применяться соответствующие санкции (бан, пессимизация).

Поисковые системы развивают нейронные сети, которые постоянно обучаются и совершенствуют свои методики анализа.

Полуавтоматический метод.

Здесь в основе также лежат поисковые алгоритмы, выявляющие подозрительные сайты. Однако принятие решения о бане или пессимизации сайта остается за модератором поисковика.

Ручной метод.

Как правило, проводится ручное исследование конкретного сайта модератором по запросу.

Чаще всего это происходит следующим образом – владелец одного сайта сообщает модератору о том, что его конкурент использует поисковый спам, после чего модератор проверяет сайт конкурента.

В разных нишах конкуренты следят друг за другом и если какой-то конкурент, что-то делает не так, то на него тут же «стучат» поисковикам.

Библиографическое описание:

Кучукова, Н. Н. Обзор методов обнаружения поискового спама с применением контент-анализа / Н. Н. Кучукова. — Текст : непосредственный // Молодой ученый. — 2012. — № 4 (39). — С. 15-17. — URL: https://moluch.ru/archive/39/4677/ (дата обращения: 25.05.2023).

Введение.

Постановка задачи

В течение

непродолжительного времени информационно-компьютерная сеть стала

одной из основных составляющих культуры, образования и, что

немаловажно, коммерческой жизни. Сегодня миллионы людей выполняют

множество финансовых операций, начиная с общебытовых (оплата товара,

использование пластиковых карт для ускорения финансовых операций), и

заканчивая взаимодействием на уровне мировых банков с использованием

веб-ресурсов. В связи с фантастическим количеством и разнообразием

информации в сети, для пользователей встает вопрос быстрого и

качественного поиска необходимой информации. Немалую роль в этом

играют поисковые системы. Учитывая введенный запрос, поисковая

система определяет соответствующие страницы в Internet

и представляет пользователям ссылки на такие страницы, как правило,

группами по 10-20 ссылок. После этого человек имеет возможность

нажать на одну из ссылок, чтобы посетить указанные страницы.

В последние несколько лет

такая модель получения соответствующей информации посредством

поисковых систем стала очень распространенной и востребованной.

Поэтому рейтинг интернет-сайтов, а вместе с тем и их коммерческая

составляющая, во многом зависит от позиции, занимаемой ими в

результатах поиска по пользовательскому запросу. В связи с этим

операторы веб-сайтов ищут методы, благодаря которым они смогут

увеличить свой рейтинг в поисковых системах. Некоторые разработчики

используют методы качественной оптимизации, такие как улучшение

качества и структуры содержания страниц, которые будут полезны

большому числу пользователей. Однако некоторые недобросовестные

операторы действуют иными, менее этическими, способами

манипулирования рейтинговой системы поисковиков. Одни включают в

себя создание посторонних страниц, ссылающихся на целевую. Иные же

используют перенасыщенность содержания страницы ключевыми словами в

надежде, что такие страницы будут высоко ранжироваться. Такая

практика искусственного повышения рейтинга получила название

поискового спама (web-спама).

Проблема

Web-спама

состоит в том, он подрывает репутацию доверенных источников. Люди

склонны относиться с результатам поиска как к беспристрастным и

достоверным, в результате с доверием пользуются предоставляемыми

ссылками. Web-спамеры рассчитывают на это доверие и на то, что люди

снова обратятся к поисковым службам для удовлетворения своих

информационных потребностей. На обработку страниц поисковыми

системами тратятся значительные ресурсы. Без применения методов

обнаружения спам-страниц поисковые системы могут затратить до седьмой

части своих ресурсов, что значительно сократит качество их работы

(это признают M.Henzinger

и другие. [3]).

По мере того, как поисковые системы позволяют поисковому спаму

влиять на качество своей работы, вполне законные сайты теряют

значительную долю репутации и влияния.

В

сообществе поисковых служб полагают, что Web-спам будет становиться

все более распространенным и изощренным. Это мнение подтверждают

статистические данные. Статистические отчеты показывают, что в 2002

г. поисковые серверы индексировали от 6 до 8 процентов страниц спама,

в 2003-2004 гг. спам составил уже 15-18%. В другом исследовании

обнаружено, что примерно в девяти процентах результатов поиска среди

первых 10 выданных ссылок содержалась, по крайней мере, одна ссылка

на спам, а в 68% случаев ссылки на спам содержались среди первых 200

ссылок. [2] Недавние исследования [4] также выявили, что 80%

пользователей поисковых систем просматривают лишь первые 3 партии

результатов. Таким образом, если ссылка на спам-сайт выдается

поисковиками среди первых, то количество его посещений увеличивается

в разы, тем самым препятствуют нахождению нужной информации.

Поэтому

перед поисковыми системами остро стоит вопрос об обнаружении

поискового спама. Создание эффективных методов их выявления —

сложная проблема. Учитывая размеры сети Internet,

он них потребуется и полная автоматизация процесса.

В

данной статье будут рассмотрены различные методы для обнаружения

поискового спама. Каждый метод хорошо подходит для распараллеливания,

работает за время, пропорциональное размеру страниц и позволяет

выявлять спам-страницы на основе контент-анализа.

Применение

контент-анализа для выявления спам-текстов.

В

данном разделе будут рассмотрены эвристики, в основе которых лежит

анализ содержания web-страницы.

На основе анализа данных эвристик можно сделать заключения о том,

имеем ли мы дело со спамом или нет.

-

Количество слов в

странице

Одним

из популярных способов создания спам-страниц является перенасыщение

наполнения web-страницы

«ключевыми словами». Текст страницы искусственно

расширяется путем добавления большого количества популярных слов, не

имеющих отношения к основному содержанию текста. В данном случае

спамеры делают ставку на то, что при смешивании произвольных слов с

искомым наполнением страницы она будет соответствовать сразу

нескольким запросам. Тем самым увеличивается вероятность того, что

большему количеству пользователей будет возвращена именно эта

страница в качестве результата на их поисковый запрос.

-

Количество слов в

заголовке страницы

Распространенной

практикой среди поисковых систем при выборе страниц, отвечающих

пользовательскому запросу, является анализ появления ключевых слов в

заголовке страницы. Некоторые поисковые системы присваивают больший

рейтинг таким страницам. В связи с этим недобросовестные создатели

сайтов пользуются этой особенностью, увеличивая количество ключевых

слов в заголовках. Данная эвристика является более эффективным

показателем спама, нежели анализ количества слов всей страницы.

-

Средняя длина слов

Относительно

редкой практикой по сравнению с предыдущими пунктами является

использование «составных» слов в спам-страницах. При

такой технике несколько слов (от двух до четырех) объединяются в одну

композицию без пробелов (например, «freedownload»).

Данный тип спама ориентирован на определенный тип запросов, когда

пользователь при наборе не учитывает расстояние между словами или

пропускает разделительные знаки.

-

Количество ссылок в

тексте страницы

Поисковые

системы довольно часто при отборе страниц анализируют текст

внутренних ссылок. Основная идея такого метода состоит в том, что

если ссылка содержит ключевое слово пользовательского запроса, то

страница, на которую она указывает, содержит информацию,

удовлетворяющую данному запросу, и возвращает ее пользователю.

Некоторые поисковые системы используют эту характеристику как

основную при ранжировании сайтов. Поэтому довольно часто применяется

такой вид спама, когда страница является просто каталогом ссылок на

другие недоброкачественные страницы.

1.5

Доля

видимого содержимого

Для

того чтобы обеспечить более релевантные результаты своим

пользователям, некоторые поисковые системы анализируют информацию

определенных html-тегов

страницы, которые не отображаются браузером. Такими элементами,

например, являются комментарии в теле кода страницы, атрибут alt

или мета-теги в заголовках. Такие элементы помогают определиться

поисковым машинам с природой страницы или изображения. Очень часто

такие «подсказки» становятся мишенью для недобросовестных

разработчиков при создании спам-страниц.

-

Анализ

естественности текста на основе наличия и разнообразия стоп-слов

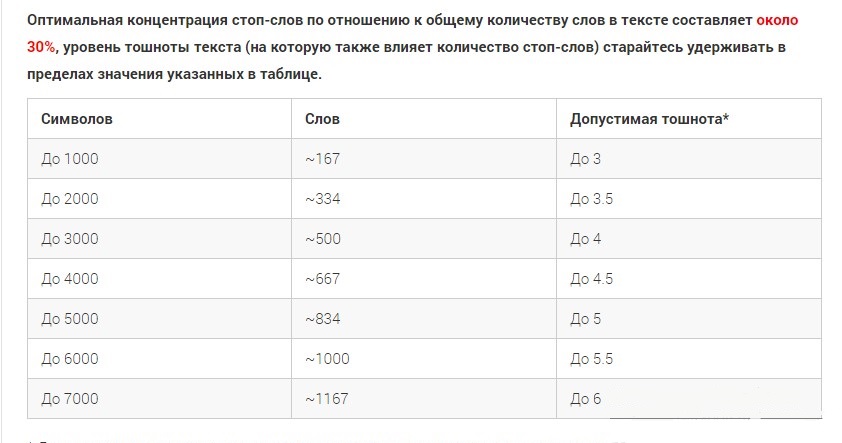

Довольно

часто при создании спам страниц учитывается эвристика предельно

допустимого количества ключевых слов в тексте. Однако данные слова

могут быть случайным образом сгенерированы на странице из словарей.

Поэтому часто проводят анализ распределения словарных слов в тексте.

Как правило, в спам-страницах наблюдается определенная равномерность

распределения слов из словарей, иная, нежели частота встречаемости

этих слов в естественном языке [5]. Довольно часто, чтобы обойти

метрику, основанную на доли стоп-слов в тексте, спамеры включают

вставку небольшого количества стоп-слов через определенные промежутки

по всему объему текста. Единственный способ идентифицировать такие

страницы как спам – проанализировать разнообразие стоп-слов.

Использование

объединенных эвристик для обнаружения поискового спама

В

предыдущем разделе был представлен ряд эвристик, эффективных при

анализе страниц на наличие спама. Однако при отдельном использовании

каждого из них может возникнуть ситуация, при которой страницы, не

содержащие спама, могут быть помечены как спам. Поэтому наиболее

эффективным оказывается метод объединенного анализа нескольких

характеристик, применяя статистические методы, с целью повышения

точности обнаружения недоброкачественных web-страниц.

В

данном случае создается модель классификатора, которая на основе

объединения нескольких параметров сможет определить страницу в одну

из категорий – спам, не спам. Общее конструирование

классификатора включает в себя его обучение анализу необходимых

параметров и модернизацию системы анализа в ходе работы. Наиболее

перспективными являются методики создания классификаторов на основе

нейронных сетей и метода опорных векторов.

Заключение

Подводя

итог проведенному обзору, можно утверждать, что для эффективной

работы поисковых систем необходимо реализовать машинно-обучаемые

методы анализа структур web-страницы

с целью обнаружения статистических совпадений со спам-структурой на

основе комбинированного выявленных эвристик.

Литература:

1.

A.Ntoulas,

M. Najork, M.Manasse, D.Fetterly. Detecting

Spam Web Pages through Content Analysis.

2.

С.Кузнецов. Что такое Web-спам?

«Открытые

системы», № 11, 2005

- 3.

M.

Henzinger, R. Motwani and C. Silverstein. Challenges in Web Search

Engines. SIGIR

Forum 36(2),

2002. -

4. B.

Jansen and A. Spink. An Analysis of Web Documents Retrieved and

Viewed. In International

Conference on Internet Computing,

June 2003. -

5.

C. Manning and H. Sch¨utze. Foundations

of Statistical Natural Language Processing.

The MIT Press, 1999, Cambridge, Massachusetts.

Основные термины (генерируются автоматически): система, слово, страница, поисковый спам, пользовательский запрос, спам, ссылка, заголовок страницы, разнообразие стоп-слов, результат поиска.

Что такое поисковый спам в SEO

Спамдексинг (spamdexing) — это несколько способов манипулирования SERP. Поисковый спам в Seo привлекает тем, что позволяет быстро достичь нужных высот в продвижении. Правда, на очень короткий срок и с риском загубить всю проводимую кампанию.

Заведем эксклюзив по твоему запросу, присоединяйся!

Что такое поисковый спам

Изначально английское слово spam означало получение нежелательных писем, чаще рекламного характера, к себе на почту. Со временем так стали называть все сообщения, которые выглядят неестественно и имеют намерение получить выгоду или смошенничать.

Веб-спам также имеет под собой замысел обмануть, но уже Гугл или Яндекс. Это делается различными способами. Например, чёрными:

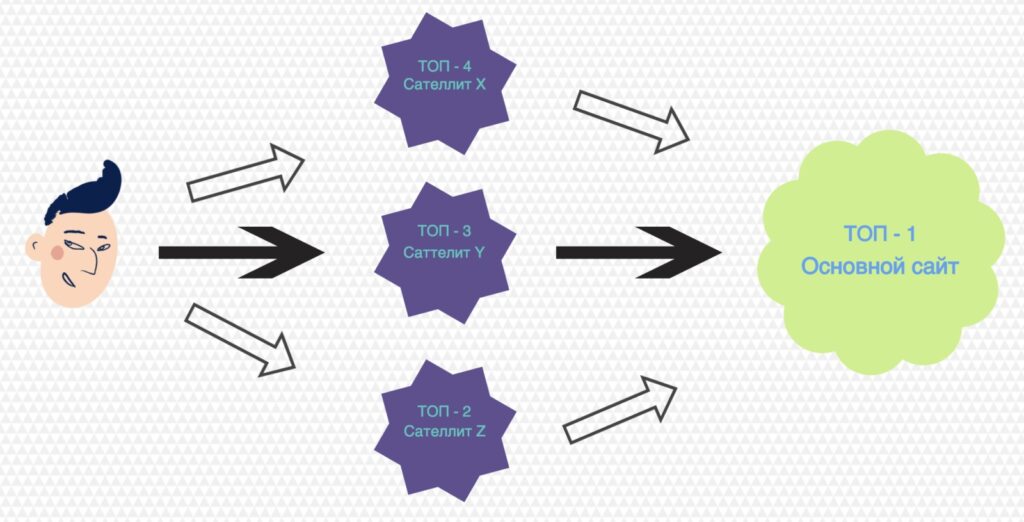

- дорвеи (doorway) — специально созданные под конкретный запрос (группу ключей) страницы, перенаправляющие трафик на другую интернет-площадку;

- клоакинг, маска (cloaking) — используется специальный код, делающий информацию на одной web-page для пользователя и поисковика совершенно разной;

- невидимые ссылки — анкором в таких линках выступают знаки препинания (точки, запятые);

- свопинг — обычно проводится на уже занявшем какие-то позиции сателлите с проиндексированным и уникальным контентом, куда впихивается бесчисленное количество фраз и ссылок на продвигаемый web-ресурс;

- линкфарминг (выращивание ссылок) — создаётся сеть не имеющих пользы одностраничников для наращивания ссылочной массы основного проекта.

Или методами помягче:

- добавление нескольких запросов в тайтл и описание (также кривые вхождения ключа);

- использование большого числа продвигаемых фраз в тексте (высокая тошнота);

- автопрогон (smile spam) — проводится рассылка объявления с упоминанием своего ресурса в каталогах, справочниках, форумах (естественно, в массовых количествах);

- рерайтинг — копируется оригинальный и полезный материал, каждое предложение текста перефразируется (выдача заполняется множеством уникальных статей, по сути, одинаковых по смыслу).

- накрутка ПФ.

Спамом поисковые системы могут посчитать и бездумную покупку ссылок веб-мастером. Пара-тройка неестественных линков — уже сигнал для алгоритмов. Фильтр последует обязательно, поэтому оптимизатору надо работать над получением естественных отсылок и рекомендаций. Гоняясь за количеством, а не качеством, оптимизатор часто покупает сотни бэков с заброшенных блогов, одностраничников, мусорных форумов и т. д.

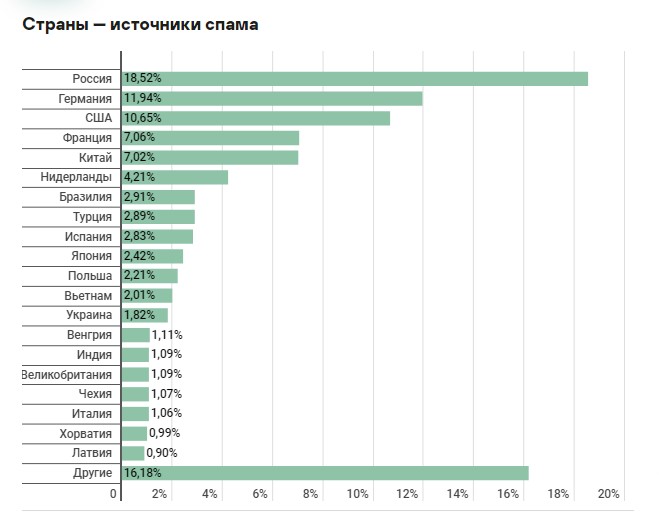

Постепенно web-spam становится всё более изощрённым. Об этом свидетельствуют статистические данные (включая обнаружение поисковыми серверами не только спама, но и фишинга):

- 2002 год — 6-8%;

- 2003-2004 — 15-18%;

- 2018 — 50%;

- 2019 — 56,5%;

- 2020 — 52,8% (только во втором квартале года).

Основными странами распространения являются Россия, Германия и США.

Очевидно, что при попадании фишингового сайта на первые три позиции SERP, количество его посещений увеличивается в несколько раз. Из-за этого пользователь не может найти полезную информацию и уходит. Получается, что борьба с мусорными сателлитами становится для поисковой системы крайне актуальной, вынужденной мерой.

Зачем и кому нужен

Все сайты с поисковым спамом (созданные специально) не имеют какого-либо информативного содержания и мало относятся к запросам юзера. Главная их задача — продвинуть основной ресурс. Некачественные страницы быстро определяются ПС и блокируются, поэтому большие средства (уникальный контент, дизайн, внешние ссылки) в них не вкладываются. Проще создать новый аналогичный лендинг со схожим дизайном и структурой.

Спамдексинг — отдельный вектор чёрной оптимизации. Применяется с целью манипуляции результатами выдачи, повышения трафика, лучшего ранжирования альфа-проекта и т. д.

Методы обнаружения поискового спама

Поисковые системы не любят спам, вводящий пользователей в заблуждение. Не найдя ответ на вопрос, они переходят на другие площадки или ещё хуже — в другую ПС. Поэтому алгоритмы находят и блокируют такие страницы.

Вот, как это обычно делается:

- Анализаторы регулярно и автоматически мониторят выдачу на наличие мусора.

- Некачественные сателлиты сами берут огонь на себя, палясь неестественными ссылками или ключами. Окончательное решение по их блокировке принимает асессор, который обязательно проверяет площадку.

- Модераторы тестируют сайты после жалоб посетителей (обычно их оставляют конкуренты). Если на площадке находят spamdexing, то она попадает под фильтр.

Одним из алгоритмов, выявляющих поисковый спам — является HITS. Он специально введён для ранжирования документов определённой тематической направленности и связан с конкретными запросами. На данный момент применяется ко всем сайтам для нахождения ядра (весомых страниц). Чтобы продвинуться в топ, «чёрный» Seo-шник обычно работает именно над авторитетными web-page.

Без применения специальных эвристик, поисковики затрачивали бы до седьмой части своих ресурсов на обнаружение спама. А это значительно ухудшает общее качества работы анализаторов, из-за чего под раздачу могут попасть хорошие и авторитетные сайты.

Ниже приведены основные методы, помогающие находить мусорные площадки:

- Высокая тошнотность (заспамленность) всего текста. Говоря иначе, его перенасыщению какими-то словами. Часто они даже не соответствуют содержанию материала, так как добавляются в целях соответствия сразу нескольким поисковым запросам. Так ловкие Seo-шники добиваются, пусть и временно, чтобы при обращении к выдаче пользователям показывалась именно их страница.

- Ключи в заголовке. Google и Yandex считают тайтлы важнейшей составляющей в определении релевантности статьи запросу. Поэтому наличие в них поисковой фразы расценивается положительно, таким web-page присваивается высокий рейтинг. Недобросовестные операторы это хорошо знают и используют в собственных целях. К примеру, нещадно увеличивают количество фраз, не чураются высокочастотными кривыми вхождениями.

- Исходящие линки. Поисковики любят ссылки, ведущие на полезные и содержательные материалы, дающие полноценный ответ. Распространитель спама это понимает, но использует данный приём по максимуму, делая из страницы просто каталог ссылок (причём на недоброкачественные ресурсы).

- Структурированные метаданные. Особенно Гугл часто анализирует определённые html-теги, не отображаемые браузером. Например, alt, keywords, title картинок и другие. Зная об этом, оптимизаторы широко используют их, пичкают сюда ключевые слова, ссылки и прочее.

- Стоп-слова. Обычно в контенте, сделанным под спам, наблюдается немного стоп-слов, вставленных через определённые промежутки по всему тексту. Определяется такой материал по неестественности и искусственности вхождения служебных частей речи.

- Составные слова. На данный момент относительно редкая практика, но когда-то широко применяемая сеошниками. При такой технике несколько слов объединялись в одну композицию без пробелов — «самсунгтелефон», «авторенодешево» и т. д. Этот вид web-spam ориентирован на такие запросы, когда пользователи при наборе не учитывают расстояние между словами и пропускают разделительные знаки. Сегодня среднестатистический юзер повысил свою интернет-грамотность, эти ошибки свелись к минимуму. Однако в своё время именно по количеству таких словосочетаний вычисляли спамные ресурсы.

Перечисленные эвристики применяются роботами в комплексе, иначе может возникнуть парадоксальная ситуация, когда web-spam помечаются качественные страницы. Наиболее эффективным становится объединённый метод анализа характеристик — точность вычисления в таком случае повышается практически до 100%.

Последствия использования поискового спама

Поисковые системы давно ведут борьбу со спамом, поэтому регулярно обновляют и совершенствуют собственные алгоритмы. Постоянно разрабатываются новые фильтры. За манипулирование выдачей наказывают по-разному, в зависимости от количества нарушений, степени вреда и т. п.

Например, перенасыщение статьи ключами может привести к падению позиций отдельной страницы (на которой опубликован материал), а за дорвеи — блокировке не только их, но и основного ресурса, а также всех связанных с ним сателлитов. Яша открыто об этом предупреждает и в подходящих случаях накладывает бан.

Гугл тоже располагает собственными фильтрами для борьбы со спамом. Однако в последнее время стал больше доверять асессорам — работникам, которые перепроверяют результаты.

| Фильтры Яндекса | |

| АГС | Введён с 2009 года, направлен на мусорные ресурсы с кучей Seo-ссылок, копипастом и низкой информативности. Как правило, обнуляет ИКС. |

| Баден-Баден | Основная задача — бороться с манипуляцией выдачи. Накладывается на сайты с переоптимизированными статьями. |

| МПК | Фильтр за малополезный контент, некорректную рекламу и спам. |

| Минусинск | Наказывает ресурсы за большое количество анкоров и неестественных ссылок. Понижает позиции страниц и ресурса в целом. |

| Бан за накрутку | Наказывают площадки, где замечена имитация действий посетителей. |

| Фильтры Гугла | |

| Panda | Назначение — косить сайты с малополезным контентом. Понижается позиция в выдаче, теряется органический трафик. |

| Supplemental Results | Недостаточно качественные, спамные страницы помещаются в дополнительный индекс, изначально скрытый от пользователей. |

| Penguin | За спам в комментариях, неестественные ссылки, переоптимизацию контента анкорами/безанкорами. |

| Фильтр за микроразметку | Накладывается в случае злоупотребления элементами мета-тегов. |

Выводы

Алгоритмы быстро находят поисковый спам, так как заинтересованы в качестве выдачи. Мусорные сайты обычно полностью блокируются, реже — накладывается фильтр на конкретные страницы.