Характеристическая функция случайной величины

Для случайной величины $xi$ характеристическая функция (ХФ) определяется следующим образом:

$$

phi_{xi}(t)=M[e^{i txi}].

$$

Для дискретной случайной величины с законом вида $(x_k,p_k)$ характеристическая функция выражается как

$$phi_{xi}(t)=M[e^{i txi}]=sum_k e^{i t x_k}cdot p_k.$$

Для непрерывной случайной величины с плотностью распределения $f(x)$:

$$phi_{xi}(t)=M[e^{i txi}]=int_{-infty}^{infty} e^{itx}cdot f(x),dx.$$

Характеристическая функция — это преобразование Фурье распределения случайной

величины.

По известной характеристической функции можно вычислять моменты случайной величины по формуле:

$$M[xi^n] = frac{1}{i^n} cdotfrac{d^n}{dx^n} phi_{xi}(t)|_{t=0}. $$

Характеристическая функция однозначно определяет распределение случайной величины. ХФ суммы независимых случайных величин равна произведению их характеристических функций (это свойство используется для доказательства композиционной устойчивости, например в примере 3 для нормального распределения). ХФ существует всегда, непрерывна, ограничена ($|phi_{xi}(t)| le 1$), в нуле равна единице.

В этом разделе вы найдете примеры нахождения характеристической функции и моментов для разных законов распределения.

Полезная страница? Сохрани или расскажи друзьям

Примеры решений: характеристическая функция

Задача 1. По заданному закону или плотности распределения случайной величины $xi$ найти характеристическую функцию $phi(t)$.

Закон Пуассона: $$P(xi=k)=a^k/k!cdot e^{-a}, k=1,2,… a=0.38$$

Задача 2. По заданному закону распределения найти характеристическую функцию $phi(t)$, кумулянтную функцию $gamma(t)$ и первые четыре семиинварианта этого распределения.

Биномиальный закон (Бернулли)

$$P(xi=k)=C_n^k p^k (1-p)^{n-k}, 0 lt p lt 1, k=0,1,2,…,n.$$

Задача 3. С помощью характеристических функций, доказать, что сумма независимых нормально распределенных случайных величин имеет нормальное распределение. Указать параметры этого распределения.

Задача 4. Найти характеристическую функцию дискретной случайной величины Х, подчиняющейся закон распределения Паскаля $P(X=m)=a^m/(1+a)^{m+1} (agt 0)$. По ней найти $M[X]$ и $D[X]$.

Задача 5. Найти характеристическую функцию непрерывной случайной величины, имеющей плотность распределения $p_{xi}(x)=e^{-|x|}/2.$

Мы отлично умеем решать задачи по теории вероятностей

3.1. Характеристическая функция биномиального закона.

Пусть с.в.

,

распределена по биномиальному закону.

Найти,

а затем выразить,,

через.

Имеет место утверждение.

Теорема 13.5. Для характеристической

функции

д.с.в.

,

распределённой по биномиальному закону

справедлива формула

(17)

.

Доказательство.По определению

случайная величинапринимает

целочисленные значенияс вероятностями

.

На основании формулы (9) и формулы бинома

Ньютона, находим

,

и с

учётом

,

равенство (17) доказано.

Упражнение. Для математического

ожидания и дисперсии биномиального

распределения и при любом целом,

вывести на основании равенства (12)

формулы:

1.

2.

3.2. Характеристическая функция закона Пуассона.

Теорема 13.6. Для характеристической

функции

д.с.в.

,

распределённой по закону Пуассона

справедлива формула

(18)

.

Доказательство. Согласно условию

теоремы с.в.принимает

только неотрицательные целые значения,

при этом

Найдём

характеристическую функцию с.в.

.

Следовательно, теорема доказана.

Упражнение. Для математического

ожидания и дисперсии распределения

Пуассона при любом целом,

ина основании равенства (12) – (15) вывести

формулы:

1.2.

Рассмотрим следующую

теоретическую задачу, которая раскрывает

ещё одну сторону закона Пуассона, где

распределение происходит с параметром,

равным произведению

.

Задача

[см. Бородин]. Число

космических частиц, попадающих в

аппаратный отсек ракеты за время её

полёта распределено по закону Пуассона

с параметром

.

При этом условная вероятность для каждой

из этих частиц попасть в уязвимый блок

равна.

Найти закон распределения

количества частиц, попадающих в уязвимый

блок.

Решение. Пусть

обозначает уязвимый блок ракеты, а

выражает наступление события, когда в

уязвимый блок ракеты попалочастиц,

иобозначает аппаратный отсек ракеты, а

выражает наступления событий, когда в

аппаратный отсек ракеты попалочастиц.

Тогда события,

,

составляют полную группу событий, по

формуле полной вероятностии с учётом того, что для

,

имеем

Далее, т.к. вероятности

гипотез согласно условию задачи равны

,

а для случаев

,

величинаопределяется

по биномиальному закону с вероятностью

«успеха» (частица попала в уязвимый

блок).

Поэтому, согласно формуле,Таким образом, окончательно получим

,

отсюда

на основании значения биномиальных

коэффициентов

,

получим

.

Таким образом, количество частиц,

попадающих в уязвимых блок ракеты также

распределены по закону Пуассона, но с

параметром, равным произведению

.

Напомним, что аналогичными формулами

мы раньше встречались в пунктах 6.2. и

9.2. в связи вероятностью наступления

потока события в случайные моменты

времени (простейшие потоки событий).

3.3. Характеристическая функция геометрического закона.

Пусть проводится неограниченное число

независимых одинаковых испытаний, в

каждом из которых событие

наступает с вероятностью

и пусть

обозначает

с.в. , равная числу испытаний до момента

первого наступления события.

Тогда эта вероятность как мы уже знаем

(см. п.9.3.) равна

.

Это распределение называется

геометрическим,так как вероятность,

как числовая последовательность образуют

геометрическую прогрессию. Тогда

вероятность того, что событиенаступит не раньше момента

,

задаётся формулой

Так как производящая функция данного

распределения (см.п.8.8.) равна

,

то согласно равенству (10) длябудем иметь

.

Упражнение. Для математического

ожидания и дисперсии геометрического

закона распределения на основании

формул (12) – (15) вывести равенства:

1.2.

3.4. Характеристическая

функция равномерного закона.

Вспомним, что равномерное распределение

для любых вещественных чисел

задается плотностью

Характеристическая функция равномерного

распределения вычисляется следующим

образом:

В частности, для центрально —

симметрического отрезка

получим

Следствие 4. В частности, справедливы

равенства

Упражнение. Для математического

ожидания и дисперсии равномерного

распределения на основании формул (12)

– (15) вывести равенства:

1.2.

Для случаявывести формулы:3.

4.

3.5. Характеристическая

функция показательного закона.

Как было показано в.9.6. плотность с.в.

,

распределённая по показательному закону

имеет

вид:

функция показательного распределения

вычисляется следующим образом:

Упражнение. Для математического

ожидания и дисперсии показательного

распределения на основании формул (12)

– (15) вывести равенства:

1.2.

3.6. Характеристическая

функция нормального закона ().

Теорема 13.7. Для характеристической

функции

с.в.

,

распределённой по нормальному закону

справедлива формула

(19)

Доказательство.Согласно формулы

(29), пункта 9.9 функция плотности с.в.определена равенством

Характеристическая

функция нормального распределения

вычисляется следующим образом:

Воспользуемся

интегралом Пуассона

,

в итоге для характеристической функции

с.в.

получим равенство

Следствие 5. Для целых значений

и

всех значения параметрасправедлива формула

.

Пример 1. Для математического

ожидания и дисперсии с.в.,

на основании формул (12) – (15) выведем

равенства:

1..

2.=

.

Применим

формулу (12):

1.,

т.е..

2.

,

т.е.

Получили

известные нам результаты. Следовательно,

с учётом с.к.о.эти параметры полностью определяют

случайные величины, распределённые по

нормальному закону.

Из рассмотренных примеров на предмет

нахождения характеристических функций

случайных величин (дискретных и

непрерывных) непосредственно следует,

что по законам распределения и функциям

плотности, а следовательно, по функциям

распределения с.в.

всегда

можно найти её характеристическую

функцию.

Оказывается, имеет место и обратное

предположение: а именно по характеристической

функции однозначно определяется функция

распределения. Рассмотрим ещё два

утверждения, относящиеся к формулам

«обращения и единственности».

Теорема 13.8 (формулы обращения).

Справедливы следующие утверждения:

1.Если с.в.

принимает

целочисленные значениято

(20)

где

мнимая

единица,.

2. Если характеристическая

функция

случайной величины

абсолютно интегрируема, то существует

плотности распределенияопределяемая формулой

(21)

.

Доказательство. Заметим, что для

любого целого числаи вещественного

имеют

место равенства

(22)

Действительно, пусть

любое вещественное число. Для

равенство очевидно. При любом

имеем

,

где мы

воспользовались равенством

Используя наше равенство для случая

,

исогласно, определению характеристической

функции с.в.с

целыми значениями, получим (с учётом

того, что для отрицательных индексов

вероятностиопределены)

Тем самым первый пункт теоремы доказан.

Перейдём к доказательству второго

пункта.

Так как функция

абсолютно интегрируема, то для любых

с учётом формулы (22) имеем

(23)

Используя

определение характеристической функции

(см. формулу (11)),

получим

(24)

(23)

Используя

определение характеристической функции

(см. формулу (11)),

получим

(24)

На основании значения интеграла Дирихле

(см. Лекции по математ. анализ Архипов

и др. гл. 17. Лекция 20.)

,

где функция определяется равенствами:

Следовательно, получим равенства

.

Поэтому,

по отдельности рассматривая случаи

и

,

получим

Пусть

и

точки

непрерывности функции.

Тогда приправая часть равенства (24)

стремится к равенству

Учитывая это равенство и на основании

(23) и (24), имеем

(25)

.

Поскольку функция распределения

непрерывна слева, то с помощью предельного

перехода из последовательности точек

непрерывности

и

функции

равенство

(25) распространяется на произвольные

точкии

.

Теперь из (25) по определению следует,

чтоявляется плотностью функции распределении

.

В итоге, из равенства (23) получим

предельное равенство.

В точках

и

непрерывности

функциисправедливо

равенство

(26)

.

Равенство

(26) носит название «формулы обращения».

Она используется для вывода весьма

важного утверждения —теорема

единственности.

Упражнение. Пустьнатуральное

число,целое число. Докажите, что

справедливы

равенства

Теорема 13. 9 (единственности).

Функция распределения однозначно

определяется своей характеристической

функцией.

Доказательство. Действительно, из

равенства (26) непосредственно следует,

что в каждой точке непрерывности функцииприменима формула

.

В

последнем интеграле предел относительноберётся относительно множеству точек

являющихся точками непрерывности

функции.

Рассмотрим некоторые примеры приложения

последней теоремы.

Пример 2. Пусть независимые случайные

величиныи

распределены по закону Пуассона, причём

Покажем,

что с.в.

распределена по закону Пуассона с

параметром.

В теореме 13.6 мы показали, что (см. (18))

.

Отсюда имеем

,

.

В силу

теоремы 13.6. характеристическая функция

суммы с.в.

равна

,

т.е. является характеристической функцией

некоторого закона Пуассона. Согласно

теореме 13.9 единственное распределение,

имеющее

своей характеристической функцией,

есть закон Пуассона, для которой

вероятность определена равенством

Замечание. Математиком Д. А. Райковым

была доказана более глубокое (обратное)

утверждение:если сумма двух независимых

с.в. распределена по закону Пуассона,

то каждое слагаемое также распределена

по закону Пуассона, т.е. верно и обратное

утверждение.

Пример 3. Если независимые

с.в.

и

распределены по нормальному закону, то

их сумматакже распределена нормально.

Действительно, если

то

соответствующие их характеристические

функции определяются (см. (19)) равенствами

,

На основании теоремы 13.7 имеем

.

Это выражение является характеристическая

функция нормального закона с математическим

ожиданием

и дисперсией

.

На основании теоремы единственности

заключаем, что функция распределения

с.в. нормальна.

В качество следующего примера без

доказательства сформулируем ещё одно

важное свойство характеристических

функций.

Пример 4. Характеристическая

функция вещественна тогда и только

тогда, когда соответствующая ей функция

распределения симметрична, другими

словами, когда при любом

функция распределения удовлетворяет

равенству

Доказательство (см. [1], глава 7, параграф

33]).

Теория характеристических функций

весьма интересная и имеет множество

изящных применений в математике и её

приложениях. Но мы этим ограничимся.

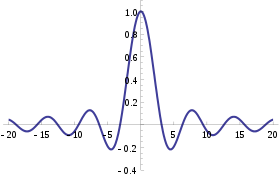

The characteristic function of a uniform U(–1,1) random variable. This function is real-valued because it corresponds to a random variable that is symmetric around the origin; however characteristic functions may generally be complex-valued.

In probability theory and statistics, the characteristic function of any real-valued random variable completely defines its probability distribution. If a random variable admits a probability density function, then the characteristic function is the Fourier transform of the probability density function. Thus it provides an alternative route to analytical results compared with working directly with probability density functions or cumulative distribution functions. There are particularly simple results for the characteristic functions of distributions defined by the weighted sums of random variables.

In addition to univariate distributions, characteristic functions can be defined for vector- or matrix-valued random variables, and can also be extended to more generic cases.

The characteristic function always exists when treated as a function of a real-valued argument, unlike the moment-generating function. There are relations between the behavior of the characteristic function of a distribution and properties of the distribution, such as the existence of moments and the existence of a density function.

Introduction[edit]

The characteristic function is a way for describing a random variable.

The characteristic function,

a function of t,

completely determines the behavior and properties of the probability distribution of the random variable X.

The characteristic function is similar to the cumulative distribution function,

(where 1{X ≤ x} is the indicator function — it is equal to 1 when X ≤ x, and zero otherwise), which also completely determines the behavior and properties of the probability distribution of the random variable X. The two approaches are equivalent in the sense that knowing one of the functions it is always possible to find the other, yet they provide different insights for understanding the features of the random variable. Moreover, in particular cases, there can be differences in whether these functions can be represented as expressions involving simple standard functions.

If a random variable admits a density function, then the characteristic function is its Fourier dual, in the sense that each of them is a Fourier transform of the other. If a random variable has a moment-generating function

[1]

Note however that the characteristic function of a distribution always exists, even when the probability density function or moment-generating function do not.

The characteristic function approach is particularly useful in analysis of linear combinations of independent random variables: a classical proof of the Central Limit Theorem uses characteristic functions and Lévy’s continuity theorem. Another important application is to the theory of the decomposability of random variables.

Definition[edit]

For a scalar random variable X the characteristic function is defined as the expected value of eitX, where i is the imaginary unit, and t ∈ R is the argument of the characteristic function:

Here FX is the cumulative distribution function of X, fX is the corresponding probability density function, QX(p) is the corresponding inverse cumulative distribution function also called the quantile function,[2] and the integrals are of the Riemann–Stieltjes kind. If a random variable X has a probability density function then the characteristic function is its Fourier transform with sign reversal in the complex exponential[3][page needed].[4] This convention for the constants appearing in the definition of the characteristic function differs from the usual convention for the Fourier transform.[5] For example, some authors[6] define φX(t) = Ee−2πitX, which is essentially a change of parameter. Other notation may be encountered in the literature:

Characteristic functions were first systematically studied by Paul Lévy, although they were used by others before him. It provides an extremely powerful tool in probability in general, and in asymptotic theory in particular. The power of the characteristic function derives from a set of highly convenient properties. Like the mgf, it determines a distribution. But unlike mgfs, existence is not an issue, and it is a bounded function. It is easily transportable for common functions of random variables, such as convolutions. And it can be used to prove convergence of distributions, as well as to recognize the name of a limiting distribution.

Generalizations[edit]

The notion of characteristic functions generalizes to multivariate random variables and more complicated random elements. The argument of the characteristic function will always belong to the continuous dual of the space where the random variable X takes its values. For common cases such definitions are listed below:

Examples[edit]

| Distribution | Characteristic function φ(t) |

|---|---|

| Degenerate δa |

|

| Bernoulli Bern(p) |

|

| Binomial B(n, p) |

|

| Negative binomial NB(r, p) |

|

| Poisson Pois(λ) |

|

| Uniform (continuous) U(a, b) |

|

| Uniform (discrete) DU(a, b) |

|

| Laplace L(μ, b) |

|

| Logistic Logistic(μ,s) |

|

| Normal N(μ, σ2) |

|

| Chi-squared χ2k |

|

| Noncentral Chi-squared χ‘2k |

|

| Cauchy C(μ, θ) |

|

| Gamma Γ(k, θ) |

|

| Exponential Exp(λ) |

|

| Geometric Gf(p) (number of failures) |

|

| Geometric Gt(p) (number of trials) |

|

| Multivariate normal N(μ, Σ) |

|

| Multivariate Cauchy MultiCauchy(μ, Σ)[10] |

|

Oberhettinger (1973) provides extensive tables of characteristic functions.

Properties[edit]

- The characteristic function of a real-valued random variable always exists, since it is an integral of a bounded continuous function over a space whose measure is finite.

- A characteristic function is uniformly continuous on the entire space.

- It is non-vanishing in a region around zero: φ(0) = 1.

- It is bounded: |φ(t)| ≤ 1.

- It is Hermitian: φ(−t) = φ(t). In particular, the characteristic function of a symmetric (around the origin) random variable is real-valued and even.

- There is a bijection between probability distributions and characteristic functions. That is, for any two random variables X1, X2, both have the same probability distribution if and only if

.

- If a random variable X has moments up to k-th order, then the characteristic function φX is k times continuously differentiable on the entire real line. In this case

- If a characteristic function φX has a k-th derivative at zero, then the random variable X has all moments up to k if k is even, but only up to k – 1 if k is odd.[11]

- If X1, …, Xn are independent random variables, and a1, …, an are some constants, then the characteristic function of the linear combination of the Xi ‘s is

One specific case is the sum of two independent random variables X1 and X2 in which case one has

- Let

and

be two random variables with characteristic functions

and

.

and

are independent if and only if

.

- The tail behavior of the characteristic function determines the smoothness of the corresponding density function.

- Let the random variable

be the linear transformation of a random variable

. The characteristic function of

is

. For random vectors

and

(where A is a constant matrix and B a constant vector), we have

.[12]

Continuity[edit]

The bijection stated above between probability distributions and characteristic functions is sequentially continuous. That is, whenever a sequence of distribution functions Fj(x) converges (weakly) to some distribution F(x), the corresponding sequence of characteristic functions φj(t) will also converge, and the limit φ(t) will correspond to the characteristic function of law F. More formally, this is stated as

- Lévy’s continuity theorem: A sequence Xj of n-variate random variables converges in distribution to random variable X if and only if the sequence φXj converges pointwise to a function φ which is continuous at the origin. Where φ is the characteristic function of X.[13]

This theorem can be used to prove the law of large numbers and the central limit theorem.

Inversion formula[edit]

There is a one-to-one correspondence between cumulative distribution functions and characteristic functions, so it is possible to find one of these functions if we know the other. The formula in the definition of characteristic function allows us to compute φ when we know the distribution function F (or density f). If, on the other hand, we know the characteristic function φ and want to find the corresponding distribution function, then one of the following inversion theorems can be used.

Theorem. If the characteristic function φX of a random variable X is integrable, then FX is absolutely continuous, and therefore X has a probability density function. In the univariate case (i.e. when X is scalar-valued) the density function is given by

In the multivariate case it is

where

The density function is the Radon–Nikodym derivative of the distribution μX with respect to the Lebesgue measure λ:

Theorem (Lévy).[note 1] If φX is characteristic function of distribution function FX, two points a < b are such that {x | a < x < b} is a continuity set of μX (in the univariate case this condition is equivalent to continuity of FX at points a and b), then

Theorem. If a is (possibly) an atom of X (in the univariate case this means a point of discontinuity of FX ) then

- If X is scalar:

- If X is a vector random variable:[15]

Theorem (Gil-Pelaez).[16] For a univariate random variable X, if x is a continuity point of FX then

where the imaginary part of a complex number

And its density function is:

The integral may be not Lebesgue-integrable; for example, when X is the discrete random variable that is always 0, it becomes the Dirichlet integral.

Inversion formulas for multivariate distributions are available.[14][17]

Criteria for characteristic functions[edit]

The set of all characteristic functions is closed under certain operations:

It is well known that any non-decreasing càdlàg function F with limits F(−∞) = 0, F(+∞) = 1 corresponds to a cumulative distribution function of some random variable. There is also interest in finding similar simple criteria for when a given function φ could be the characteristic function of some random variable. The central result here is Bochner’s theorem, although its usefulness is limited because the main condition of the theorem, non-negative definiteness, is very hard to verify. Other theorems also exist, such as Khinchine’s, Mathias’s, or Cramér’s, although their application is just as difficult. Pólya’s theorem, on the other hand, provides a very simple convexity condition which is sufficient but not necessary. Characteristic functions which satisfy this condition are called Pólya-type.[18]

Bochner’s theorem. An arbitrary function φ : Rn → C is the characteristic function of some random variable if and only if φ is positive definite, continuous at the origin, and if φ(0) = 1.

Khinchine’s criterion. A complex-valued, absolutely continuous function φ, with φ(0) = 1, is a characteristic function if and only if it admits the representation

Mathias’ theorem. A real-valued, even, continuous, absolutely integrable function φ, with φ(0) = 1, is a characteristic function if and only if

for n = 0,1,2,…, and all p > 0. Here H2n denotes the Hermite polynomial of degree 2n.

Pólya’s theorem can be used to construct an example of two random variables whose characteristic functions coincide over a finite interval but are different elsewhere.

Pólya’s theorem. If

then φ(t) is the characteristic function of an absolutely continuous distribution symmetric about 0.

Uses[edit]

Because of the continuity theorem, characteristic functions are used in the most frequently seen proof of the central limit theorem. The main technique involved in making calculations with a characteristic function is recognizing the function as the characteristic function of a particular distribution.

Basic manipulations of distributions[edit]

Characteristic functions are particularly useful for dealing with linear functions of independent random variables. For example, if X1, X2, …, Xn is a sequence of independent (and not necessarily identically distributed) random variables, and

where the ai are constants, then the characteristic function for Sn is given by

In particular, φX+Y(t) = φX(t)φY(t). To see this, write out the definition of characteristic function:

The independence of X and Y is required to establish the equality of the third and fourth expressions.

Another special case of interest for identically distributed random variables is when ai = 1/n and then Sn is the sample mean. In this case, writing X for the mean,

Moments[edit]

Characteristic functions can also be used to find moments of a random variable. Provided that the nth moment exists, the characteristic function can be differentiated n times and

For example, suppose X has a standard Cauchy distribution. Then φX(t) = e−|t|. This is not differentiable at t = 0, showing that the Cauchy distribution has no expectation. Also, the characteristic function of the sample mean X of n independent observations has characteristic function φX(t) = (e−|t|/n)n = e−|t|, using the result from the previous section. This is the characteristic function of the standard Cauchy distribution: thus, the sample mean has the same distribution as the population itself.

As a further example, suppose X follows a Gaussian distribution i.e.

A similar calculation shows ![{displaystyle operatorname {E} left[X^{2}right]=mu ^{2}+sigma ^{2}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e724a4d6ebe2c549c0d8e15be5e90b516736db3d)

![{displaystyle operatorname {E} left[X^{2}right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c1870531fc3ee86b5deedeaedf9363b5cdd419b0)

The logarithm of a characteristic function is a cumulant generating function, which is useful for finding cumulants; some instead define the cumulant generating function as the logarithm of the moment-generating function, and call the logarithm of the characteristic function the second cumulant generating function.

Data analysis[edit]

Characteristic functions can be used as part of procedures for fitting probability distributions to samples of data. Cases where this provides a practicable option compared to other possibilities include fitting the stable distribution since closed form expressions for the density are not available which makes implementation of maximum likelihood estimation difficult. Estimation procedures are available which match the theoretical characteristic function to the empirical characteristic function, calculated from the data. Paulson et al. (1975)[19] and Heathcote (1977)[20] provide some theoretical background for such an estimation procedure. In addition, Yu (2004)[21] describes applications of empirical characteristic functions to fit time series models where likelihood procedures are impractical. Empirical characteristic functions have also been used by Ansari et al. (2020)[22] and Li et al. (2020)[23] for training generative adversarial networks.

Example[edit]

The gamma distribution with scale parameter θ and a shape parameter k has the characteristic function

Now suppose that we have

with X and Y independent from each other, and we wish to know what the distribution of X + Y is. The characteristic functions are

which by independence and the basic properties of characteristic function leads to

This is the characteristic function of the gamma distribution scale parameter θ and shape parameter k1 + k2, and we therefore conclude

The result can be expanded to n independent gamma distributed random variables with the same scale parameter and we get

Entire characteristic functions[edit]

|

This section needs expansion. You can help by adding to it. (December 2009) |

As defined above, the argument of the characteristic function is treated as a real number: however, certain aspects of the theory of characteristic functions are advanced by extending the definition into the complex plane by analytical continuation, in cases where this is possible.[24]

[edit]

Related concepts include the moment-generating function and the probability-generating function. The characteristic function exists for all probability distributions. This is not the case for the moment-generating function.

The characteristic function is closely related to the Fourier transform: the characteristic function of a probability density function p(x) is the complex conjugate of the continuous Fourier transform of p(x) (according to the usual convention; see continuous Fourier transform – other conventions).

where P(t) denotes the continuous Fourier transform of the probability density function p(x). Likewise, p(x) may be recovered from φX(t) through the inverse Fourier transform:

Indeed, even when the random variable does not have a density, the characteristic function may be seen as the Fourier transform of the measure corresponding to the random variable.

Another related concept is the representation of probability distributions as elements of a reproducing kernel Hilbert space via the kernel embedding of distributions. This framework may be viewed as a generalization of the characteristic function under specific choices of the kernel function.

See also[edit]

- Subindependence, a weaker condition than independence, that is defined in terms of characteristic functions.

- Cumulant, a term of the cumulant generating functions, which are logs of the characteristic functions.

Notes[edit]

- ^ named after the French mathematician Paul Lévy

References[edit]

Citations[edit]

- ^ Lukacs (1970), p. 196.

- ^ Shaw, W. T.; McCabe, J. (2009). «Monte Carlo sampling given a Characteristic Function: Quantile Mechanics in Momentum Space». arXiv:0903.1592 [q-fin.CP].

- ^ Statistical and Adaptive Signal Processing (2005)

- ^ Billingsley (1995).

- ^ Pinsky (2002).

- ^ Bochner (1955).

- ^ Andersen et al. (1995), Definition 1.10.

- ^ Andersen et al. (1995), Definition 1.20.

- ^ Sobczyk (2001), p. 20.

- ^ Kotz & Nadarajah (2004), p. 37 using 1 as the number of degree of freedom to recover the Cauchy distribution

- ^ Lukacs (1970), Corollary 1 to Theorem 2.3.1.

- ^ «Joint characteristic function». www.statlect.com. Retrieved 7 April 2018.

- ^ Cuppens (1975), Theorem 2.6.9.

- ^ a b c Shephard (1991a).

- ^ Cuppens (1975), Theorem 2.3.2.

- ^ Wendel (1961).

- ^ Shephard (1991b).

- ^ Lukacs (1970), p. 84.

- ^ Paulson, Holcomb & Leitch (1975).

- ^ Heathcote (1977).

- ^ Yu (2004).

- ^ Ansari, Scarlett & Soh (2020).

- ^ Li et al. (2020).

- ^ Lukacs (1970), Chapter 7.

Sources[edit]

- Andersen, H.H.; Højbjerre, M.; Sørensen, D.; Eriksen, P.S. (1995). Linear and graphical models for the multivariate complex normal distribution. Lecture Notes in Statistics 101. New York: Springer-Verlag. ISBN 978-0-387-94521-7.

- Billingsley, Patrick (1995). Probability and measure (3rd ed.). John Wiley & Sons. ISBN 978-0-471-00710-4.

- Bisgaard, T. M.; Sasvári, Z. (2000). Characteristic functions and moment sequences. Nova Science.

- Bochner, Salomon (1955). Harmonic analysis and the theory of probability. University of California Press.

- Cuppens, R. (1975). Decomposition of multivariate probabilities. Academic Press. ISBN 9780121994501.

- Heathcote, C.R. (1977). «The integrated squared error estimation of parameters». Biometrika. 64 (2): 255–264. doi:10.1093/biomet/64.2.255.

- Lukacs, E. (1970). Characteristic functions. London: Griffin.

- Kotz, Samuel; Nadarajah, Saralees (2004). Multivariate T Distributions and Their Applications. Cambridge University Press.

- Manolakis, Dimitris G.; Ingle, Vinay K.; Kogon, Stephen M. (2005). Statistical and Adaptive Signal Processing: Spectral Estimation, Signal Modeling, Adaptive Filtering, and Array Processing. Artech House. ISBN 978-1-58053-610-3.

- Oberhettinger, Fritz (1973). Fourier transforms of distributions and their inverses; a collection of tables. New York: Academic Press. ISBN 9780125236508.

- Paulson, A.S.; Holcomb, E.W.; Leitch, R.A. (1975). «The estimation of the parameters of the stable laws». Biometrika. 62 (1): 163–170. doi:10.1093/biomet/62.1.163.

- Pinsky, Mark (2002). Introduction to Fourier analysis and wavelets. Brooks/Cole. ISBN 978-0-534-37660-4.

- Sobczyk, Kazimierz (2001). Stochastic differential equations. Kluwer Academic Publishers. ISBN 978-1-4020-0345-5.

- Wendel, J.G. (1961). «The non-absolute convergence of Gil-Pelaez’ inversion integral». The Annals of Mathematical Statistics. 32 (1): 338–339. doi:10.1214/aoms/1177705164.

- Yu, J. (2004). «Empirical characteristic function estimation and its applications». Econometrics Reviews. 23 (2): 93–1223. doi:10.1081/ETC-120039605. S2CID 9076760.

- Shephard, N. G. (1991a). «From characteristic function to distribution function: A simple framework for the theory». Econometric Theory. 7 (4): 519–529. doi:10.1017/s0266466600004746. S2CID 14668369.

- Shephard, N. G. (1991b). «Numerical integration rules for multivariate inversions». J. Statist. Comput. Simul. 39 (1–2): 37–46. doi:10.1080/00949659108811337.

- Ansari, Abdul Fatir; Scarlett, Jonathan; Soh, Harold (2020). «A Characteristic Function Approach to Deep Implicit Generative Modeling». Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020. pp. 7478–7487.

- Li, Shengxi; Yu, Zeyang; Xiang, Min; Mandic, Danilo (2020). «Reciprocal Adversarial Learning via Characteristic Functions». Advances in Neural Information Processing Systems 33 (NeurIPS 2020).

External links[edit]

- «Characteristic function», Encyclopedia of Mathematics, EMS Press, 2001 [1994]

![varphi _{X}(t)=operatorname {E} left[e^{itX}right],](https://wikimedia.org/api/rest_v1/media/math/render/svg/220ee899de62e4b930fbe4ac3a92c2e9544b2b8d)

![F_{X}(x)=operatorname {E} left[mathbf {1} _{{Xleq x}}right]](https://wikimedia.org/api/rest_v1/media/math/render/svg/60d71e50c71db8ecbb3c1c4301ee7a449cf637fd)

![{displaystyle {begin{cases}displaystyle varphi _{X}!:mathbb {R} to mathbb {C} \displaystyle varphi _{X}(t)=operatorname {E} left[e^{itX}right]=int _{mathbb {R} }e^{itx},dF_{X}(x)=int _{mathbb {R} }e^{itx}f_{X}(x),dx=int _{0}^{1}e^{itQ_{X}(p)},dpend{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/326c33a2ba687a8901958c089ac9d3f8ac8945ff)

![{displaystyle operatorname {E} [X^{k}]=i^{-k}varphi _{X}^{(k)}(0).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8b4d9670c5a208c90e576d3dd9e2a67d9f62b3ec)

![{displaystyle varphi _{X}^{(k)}(0)=i^{k}operatorname {E} [X^{k}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/278511590ecd7122a91abb28362f99a9783231c7)

![{displaystyle mu _{X}({a})=lim _{T_{1}to infty }cdots lim _{T_{n}to infty }left(prod _{k=1}^{n}{frac {1}{2T_{k}}}right)int limits _{[-T_{1},T_{1}]times dots times [-T_{n},T_{n}]}e^{-i(tcdot a)}varphi _{X}(t)lambda (dt)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a6091d2bd8a86072cd6e9c4eba20d2d26588d6a9)

![{displaystyle F_{X}(x)={frac {1}{2}}-{frac {1}{pi }}int _{0}^{infty }{frac {operatorname {Im} [e^{-itx}varphi _{X}(t)]}{t}},dt}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cdb024609abbc854a4a74dfaaaaafbe19bf76879)

![{displaystyle f_{X}(x)={frac {1}{pi }}int _{0}^{infty }operatorname {Re} [e^{-itx}varphi _{X}(t)],dt}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2f64a523e775dc962adb40df5614c84ee2d58856)

![{displaystyle varphi _{X+Y}(t)=operatorname {E} left[e^{it(X+Y)}right]=operatorname {E} left[e^{itX}e^{itY}right]=operatorname {E} left[e^{itX}right]operatorname {E} left[e^{itY}right]=varphi _{X}(t)varphi _{Y}(t)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3a2f8a4335407b6acbee44bfd54d8c5c2e59b1d5)

![{displaystyle left[{frac {d^{n}}{dt^{n}}}varphi _{X}(t)right]_{t=0}=i^{n}operatorname {E} left[X^{n}right]Rightarrow operatorname {E} left[X^{n}right]=i^{-n}left[{frac {d^{n}}{dt^{n}}}varphi _{X}(t)right]_{t=0}=i^{-n}varphi _{X}^{(n)}(0),!}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2a02a7ddbebf6662ec3711f2528178c77f391af8)

![{displaystyle operatorname {E} left[Xright]=i^{-1}left[{frac {d}{dt}}varphi _{X}(t)right]_{t=0}=i^{-1}left[(imu -sigma ^{2}t)varphi _{X}(t)right]_{t=0}=mu }](https://wikimedia.org/api/rest_v1/media/math/render/svg/41462bb40acf2fc9e7a4fd41a5c6fd84b369be1c)